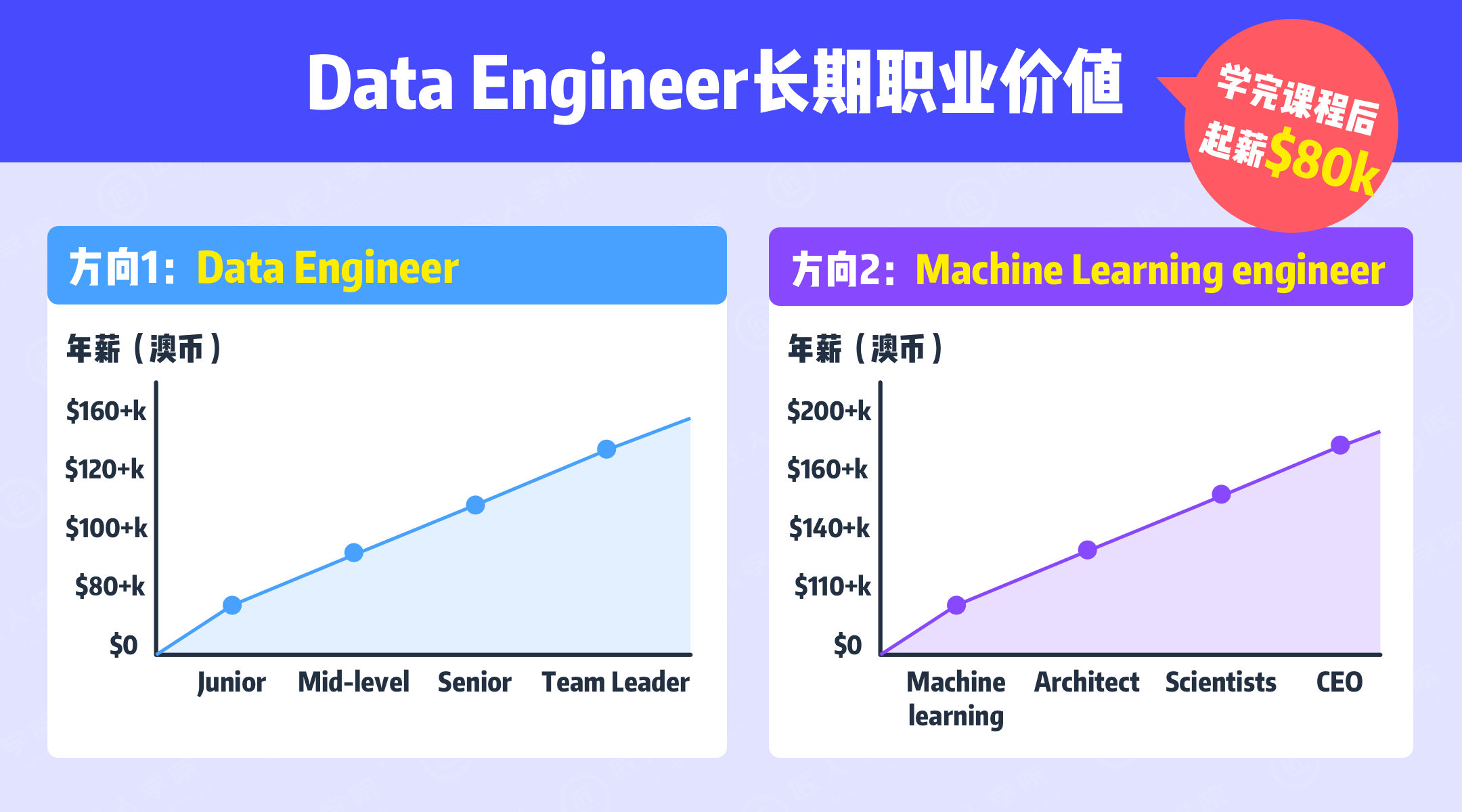

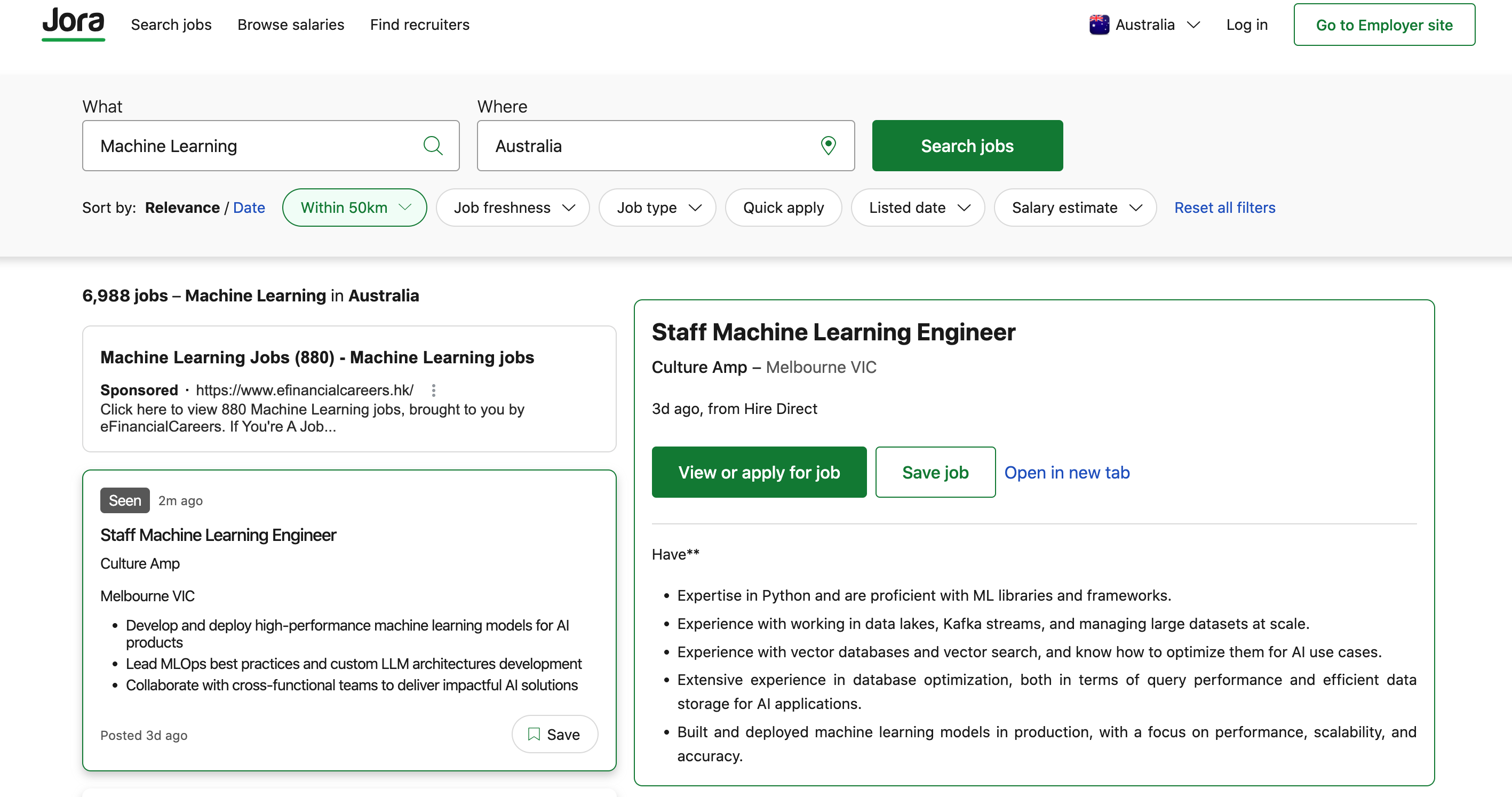

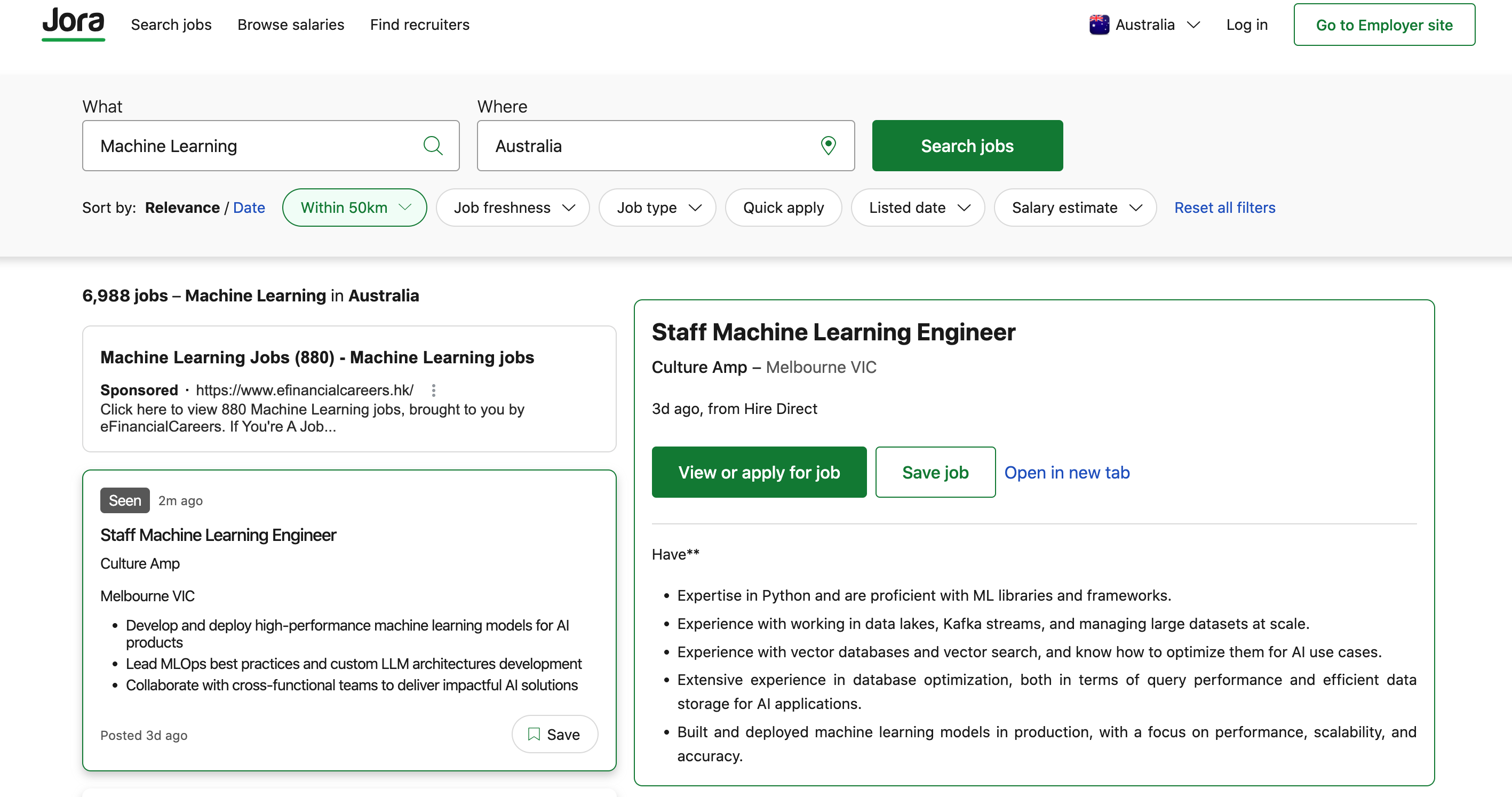

在Gen AI 高速发展的今天,数据工程师的角色正在发生深刻转变。企业不再满足于“搬数据、管流程”的传统数据处理能力,而是更需要既懂数据架构、又能对接 AI 模型,具备全链路“数据→智能”交付能力的新一代全栈数据工程师、ML Engineer。目前澳洲的机器学习工程师岗位需求非常旺盛,共有超过 300 个职位在 Indeed 网站上发布。Jora 网站列出了超过 5,400 个相关职位,薪资范围从每年 10 万美元(约 145,000 澳元)到 20 万美元(约 290,000 澳元)不等,取决于经验和职位。

为顺应行业趋势,我们在原有“数据工程 + 大数据 + 云计算”体系上,重磅升级了 Machine Learning 与 AI 应用模块,推出全新 7.0 课程体系。

新升级课程,全面融合 Machine Learning 和 Retrieval-Augmented Generation (RAG) 全流程实战技术,上手 AI 领域最前沿的解决方案!

新升级的课程也适合留学生回国就业

课程升级的必要性

岗位需求变化:澳洲与全球主流科技公司纷纷在数据平台团队中引入 ML Engineer / LLM Integrator / Data Product Owner 等新型混合岗位

工具与平台演进:SageMaker、Qdrant、OpenAI API、LangChain 等新工具成为团队必备能力

项目场景升级:从传统可视化报表 → 实时数据驱动 → 智能问答与推荐,数据系统正走向 AI 化、服务化

课程也能满足澳洲留学生回国就业所需技能,国内阿里、字节跳动、腾讯、科大讯飞等大厂都在大力招聘机器学习工程师

课程大纲升级亮点解析

引入完整 Machine Learning 流程教学:从算法到部署,掌握企业级模型训练管道

新增 RAG 架构实战模块:打造真实场景下的智能问答与推荐系统,使用向量数据库 + LLM 构建语义搜索引擎

全面覆盖 AI+DE 全链路技术体系:从数据存储、数据处理、ML建模到 AI 应用开发,一站式掌握职场刚需技能

三个月学习+项目实战,全方位成为 AI 时代的数据工程师

课程培养学员具备数据工程技术、大数据处理、AWS、Machine Learning和Gen AI 实战能力,帮助学员打通从数据存储、模型训练到应用部署的全链路技术思维。

课程大纲7.0三大新升级

✨ 新增 1: Machine Learning 全流程实战

全面融合算法技术和实际应用,包括:

ML基础算法:Linear Regression,Logistic Regression,Decision Tree,Random Forest,KMeans Clustering,SVM,Naive Bayes

用 Spark MLlib 实现分类/聚类算法,处理分布很大的数据量

使用 OpenAI Embedding 生成文本向量,实现文本分类/搜索/推荐

AWS SageMaker 上训练、模型部署和 Endpoint API 接入

搭建自己的机器学习 Web App,支持推荐、预测、分析功能

✨ 新增 2: AI RAG (检索增强生成) 架构实战

完整实战系列,打造可部署的智能推荐和问答系统:

实战课程:Introduction to LLM & RAG for Recommendations

介绍 LLM 与 RAG 核心模型和工作原理,分析与传统推荐系统的区别

数据准备:标准化产品列表,数据清洗,产品描述 embedding

向量库选型和实现:Qdrant 搭建向量搜索基础,支持快速相似度检索

构建全流程 RAG 系统:问题向量化,文档搜索,上下文组装,LLM生成,Post-processing 输出

搭建对话界面:使用 Streamlit/前端框架实现应用结果输出

容器化部署:使用 Docker 部署整套服务,包括前端+API+Qdrant

✨ 新增 3: AI+DE 联合项目实战

基础步骤 + 项目实战 + 就业资源,一路打通

第一阶段:数据工程基础矩阵

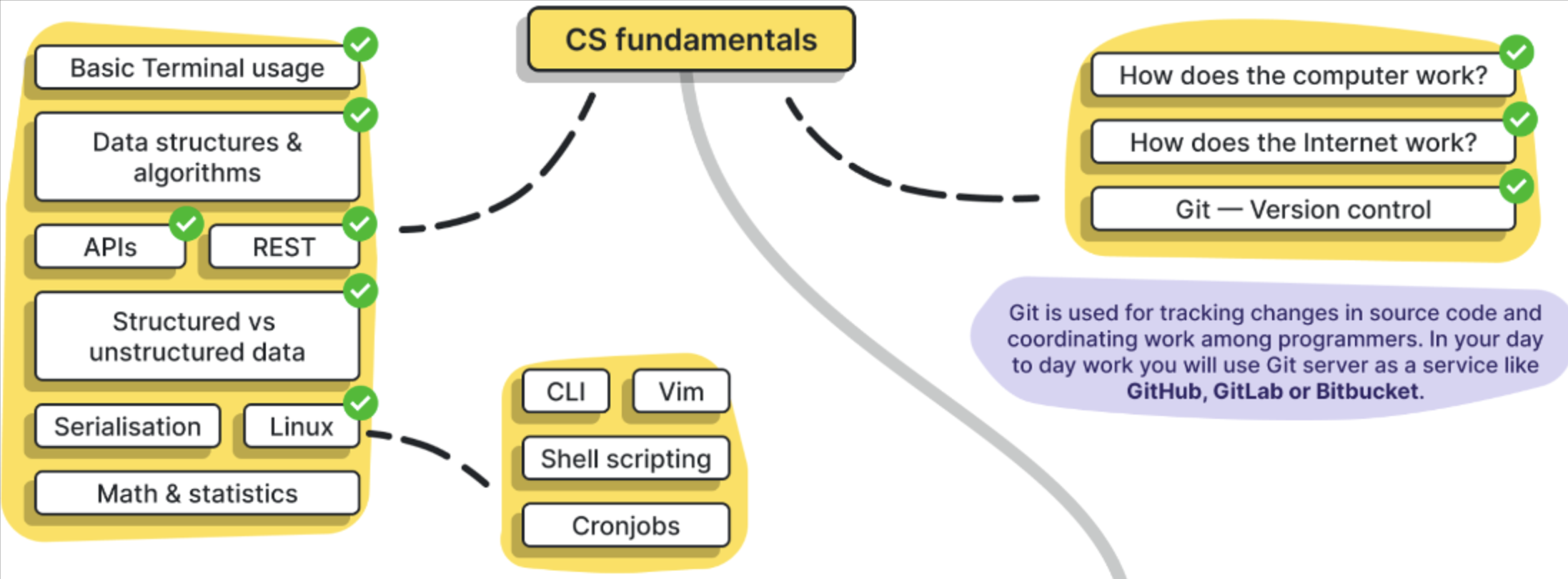

Python 基础、Linux 命令行、Git/Github CI/CD 组织合作

数据格式、数据清洗、SQL 高级经典操作

数据存储: PostgreSQL 和问卷数据库,数据模型设计

数据存储和搜索: Data Warehouse (Redshift), Data Lake (S3)

ETL 流程:Airflow + Python 实现数据投入、处理、删重

第二阶段:大数据 & 云服务技术

第三阶段:AI技术入门 + 实战化项目

同步进入 ML 算法 + LLM API + RAG 项目培成

项目包括智能推荐、云部署分析、自动化管道、Docker部署

学员最终成果可以搭建一套自己的 AI+DE 数据系统

第四阶段:简历打造 + 内推资源

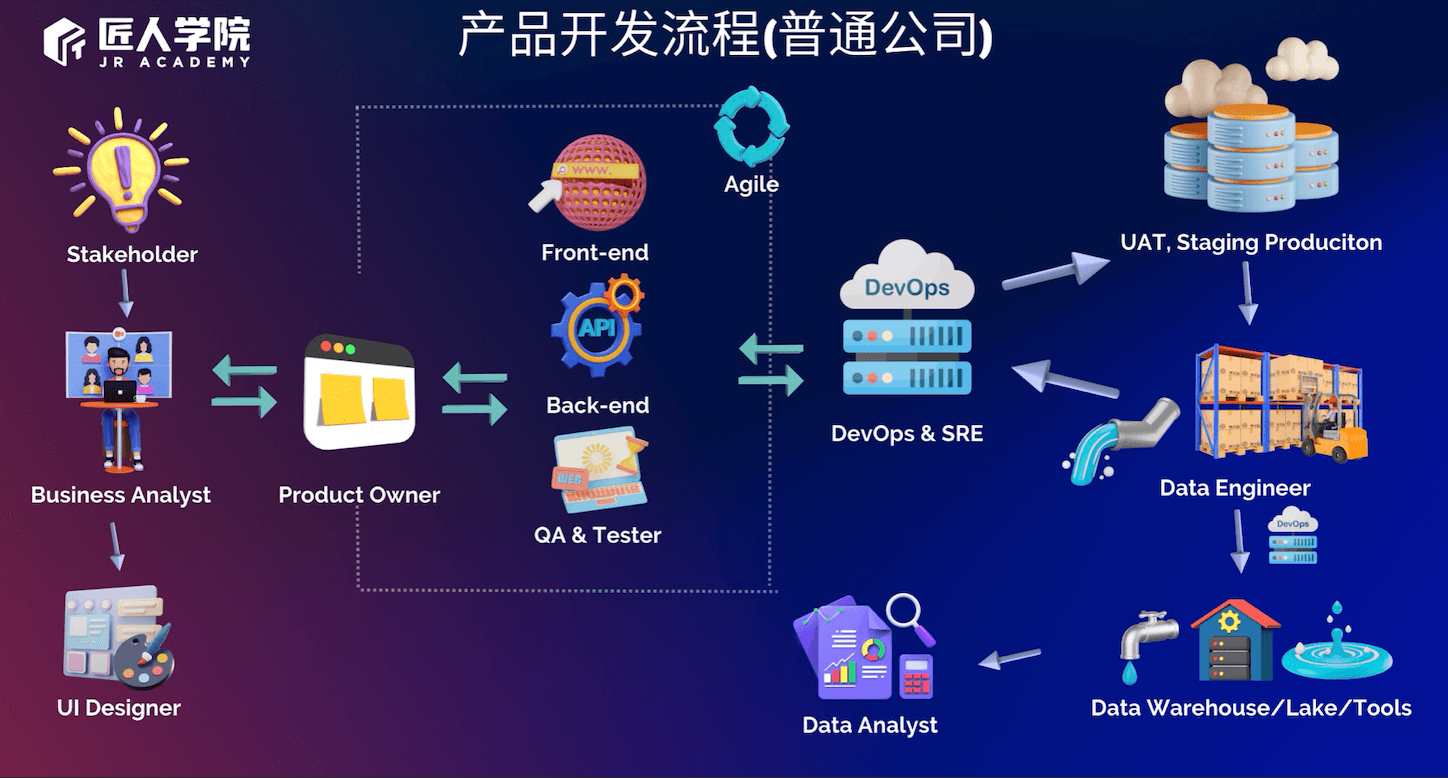

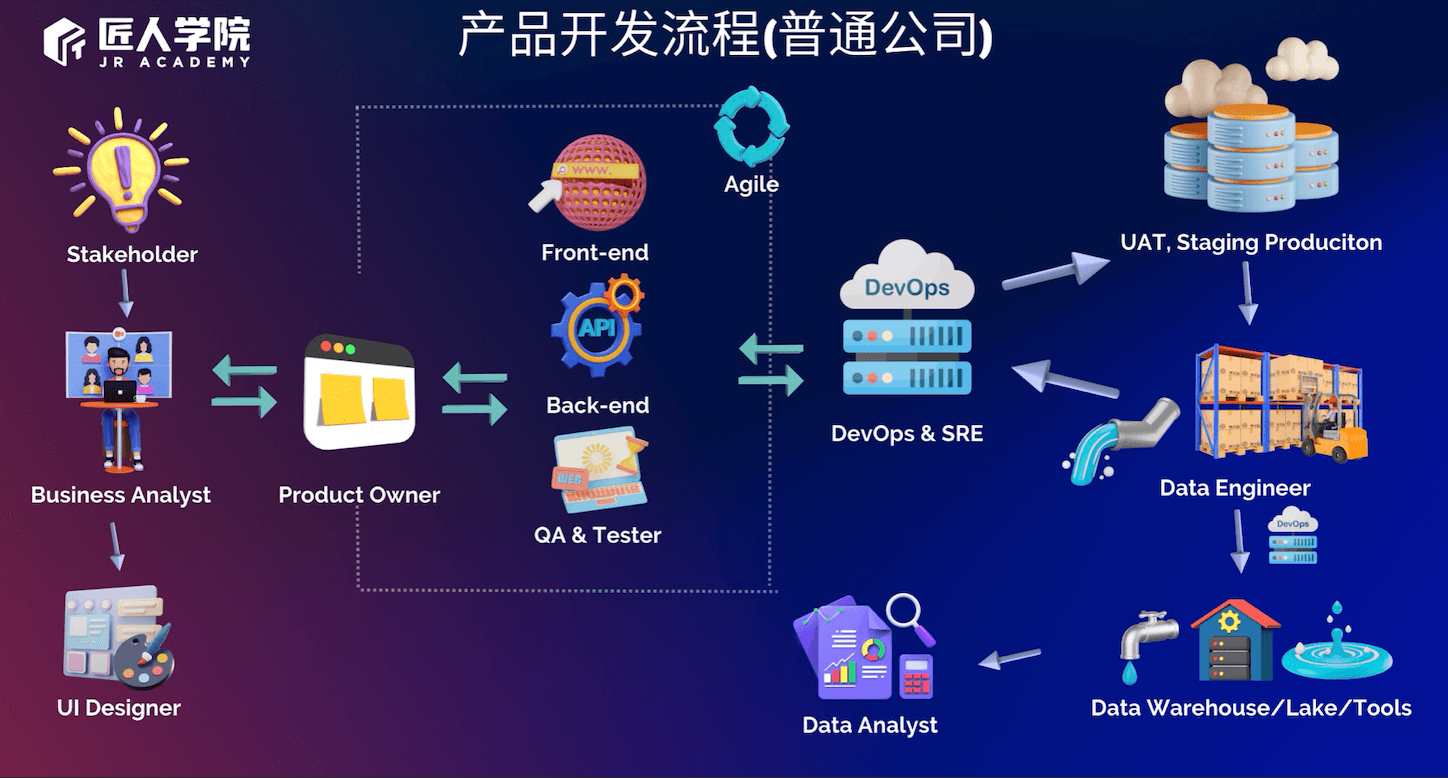

什么是数据工程?

数据工程是指面向不同计算平台和应用环境,使用信息系统设计,开发和评价的工程化技术和方法,一般被广泛应用于数据的传输,转换和储存。像如何高效存储海量的数据,利用实时数据反馈用户状况,以及利用机器学习来实现精准推荐等都是数据工程所研究的方向。

什么是数据工程师?

数据工程师在大数据时代或者被称为数据架构师更准确,工作的重点更偏向于数据架构,计算,数据存储,数据流,数据库设计等方向。因此数据工程师会对编程要求更高一点。

数据工程师的工作内容

数据工程师就像餐厅的主厨一样,为了给大家呈现精美的菜肴,首先需要进货,购买一些蔬菜和鸡鸭鱼肉,而这些原始食材就相当于source data一样。

当通过不同的方式得到原数据后,DE需要通过各种方式处理好这些数据,就类似厨师需要给鱼刮刮鳞,鸡要去毛,肉要腌制等;初步处理完毕后,还要把各种食材切成不同的形状,所有这些食物材料的处理,就相当于data transformation和data cleansing。

食材处理完毕后,需要烹饪成菜肴,比如说有些菜需要蒸,有些菜需要炸,那么厨师就会以相应的方式去烹饪这道菜,这就类似于数据工程中有时候需要处理好的数据以dashboard的形式去展现出,有时候需要用处理好的数据去训练ML的model。

有些时候,处理好的数据不需要立刻做成菜肴,那么厨师就会把这些食材放进冰箱,这就相当于数据工程中的data backup操作 - 把处理好的数据先backup到某个地方,之后有product需要这些处理好的数据时,再拿出来用。

从原食材到最终呈现给顾客的这整个过程,就相当于把源数据变为数据产品的整个过程。作为主厨,还需要通过不同的方式,去收集食客的反馈,才可以改进菜肴的味道,这相当于在数据工程中,收集用户的反馈,并根据反馈来改进各个环节的数据操作。

数据工程师 DE vs 数据分析师 DA vs 数据科学家 DS

数据分析师主要是负责收集处理数据以及对数据进行可视化展示,而数据工程师更多负责搭建数据结构,以及大量使用云技术与 DevOps 合作进行云端环境的搭建。数据科学家则对更注重于数据模型,机器学习以及数据挖掘等方面。

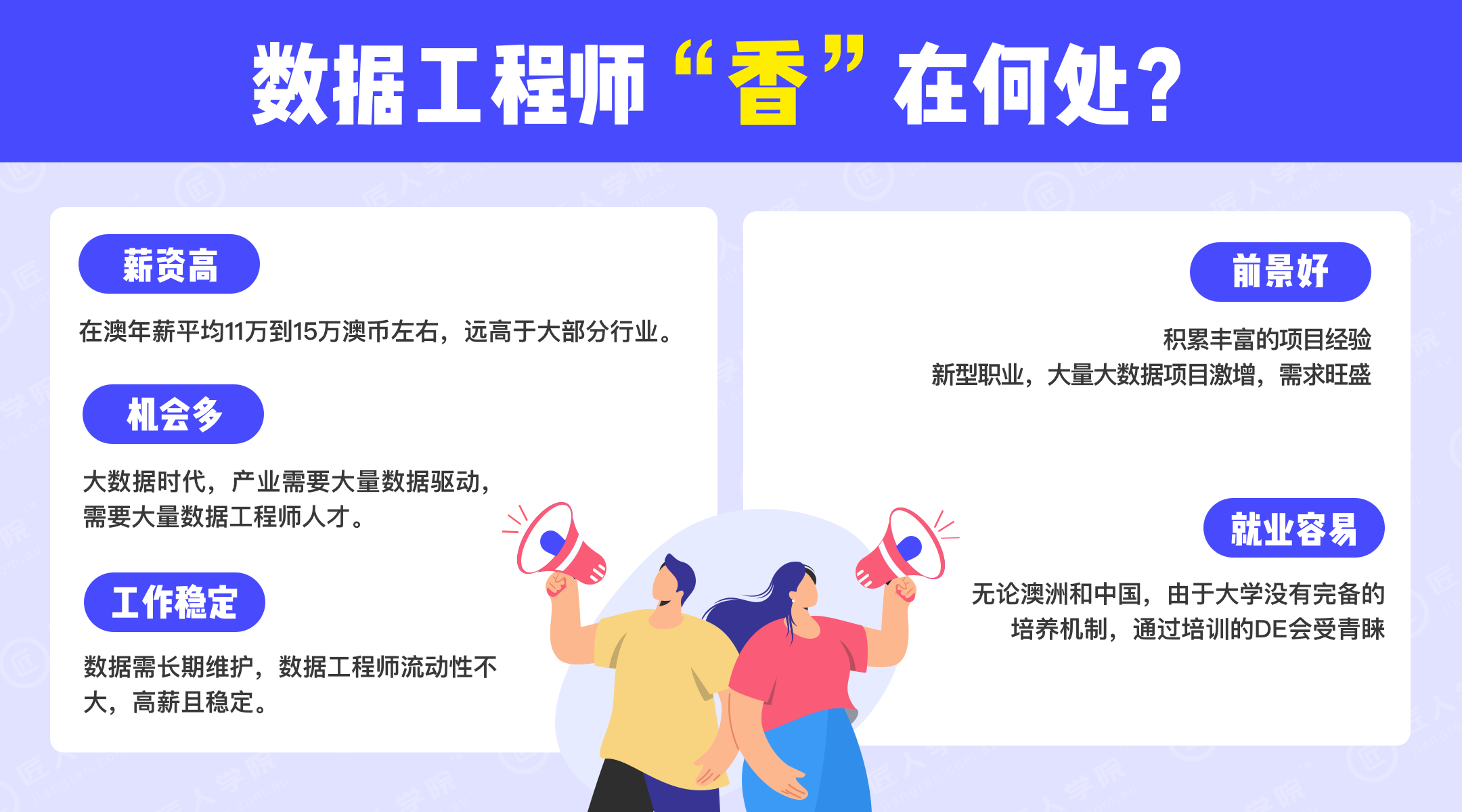

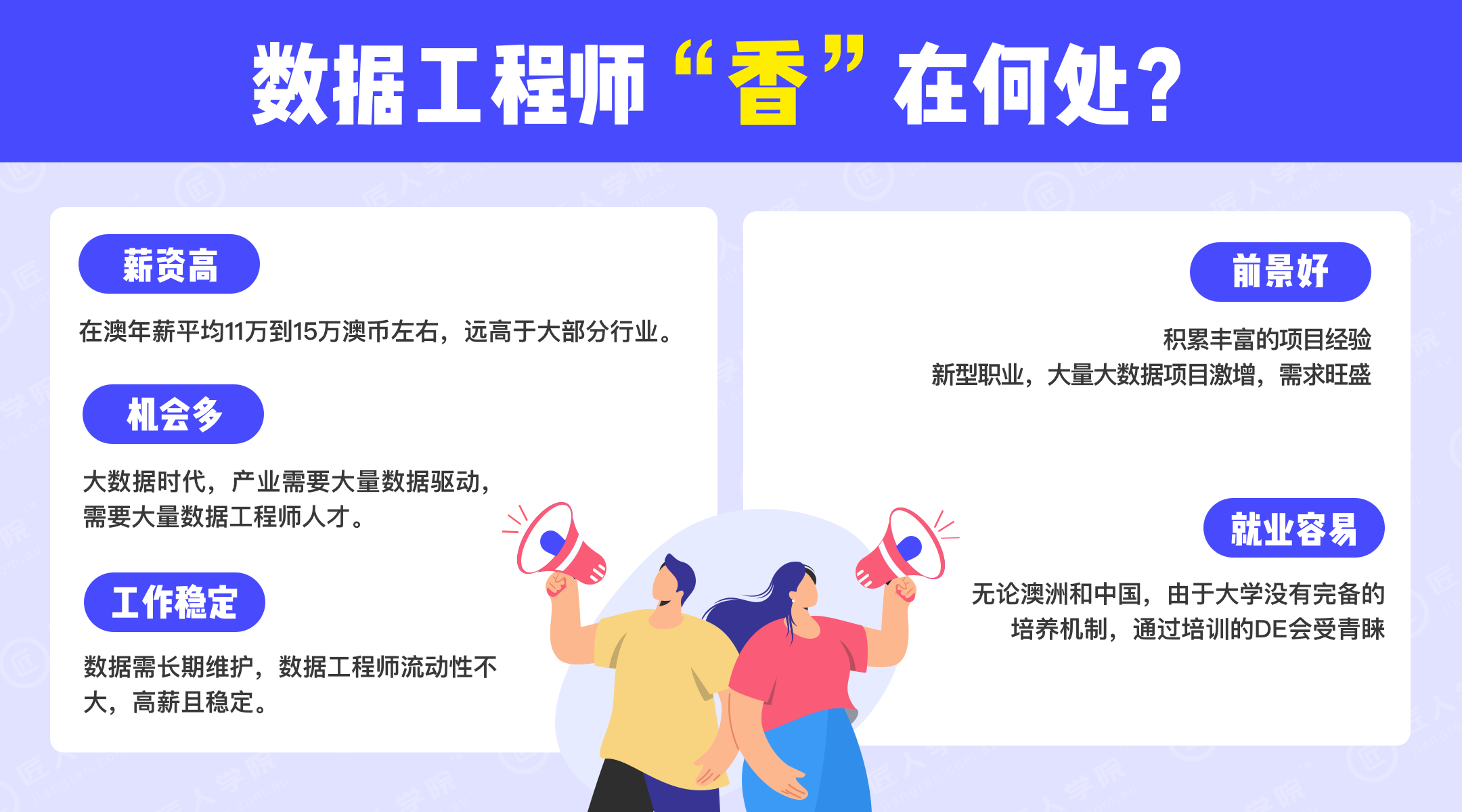

为什么要学数据工程?

而且由于数据需要长期维护,所以数据工程师工作相对稳定,但是无论是在澳洲还是在中国都没有一个完善的培养机制,通过培训的数据工程师会相对更受青睐。

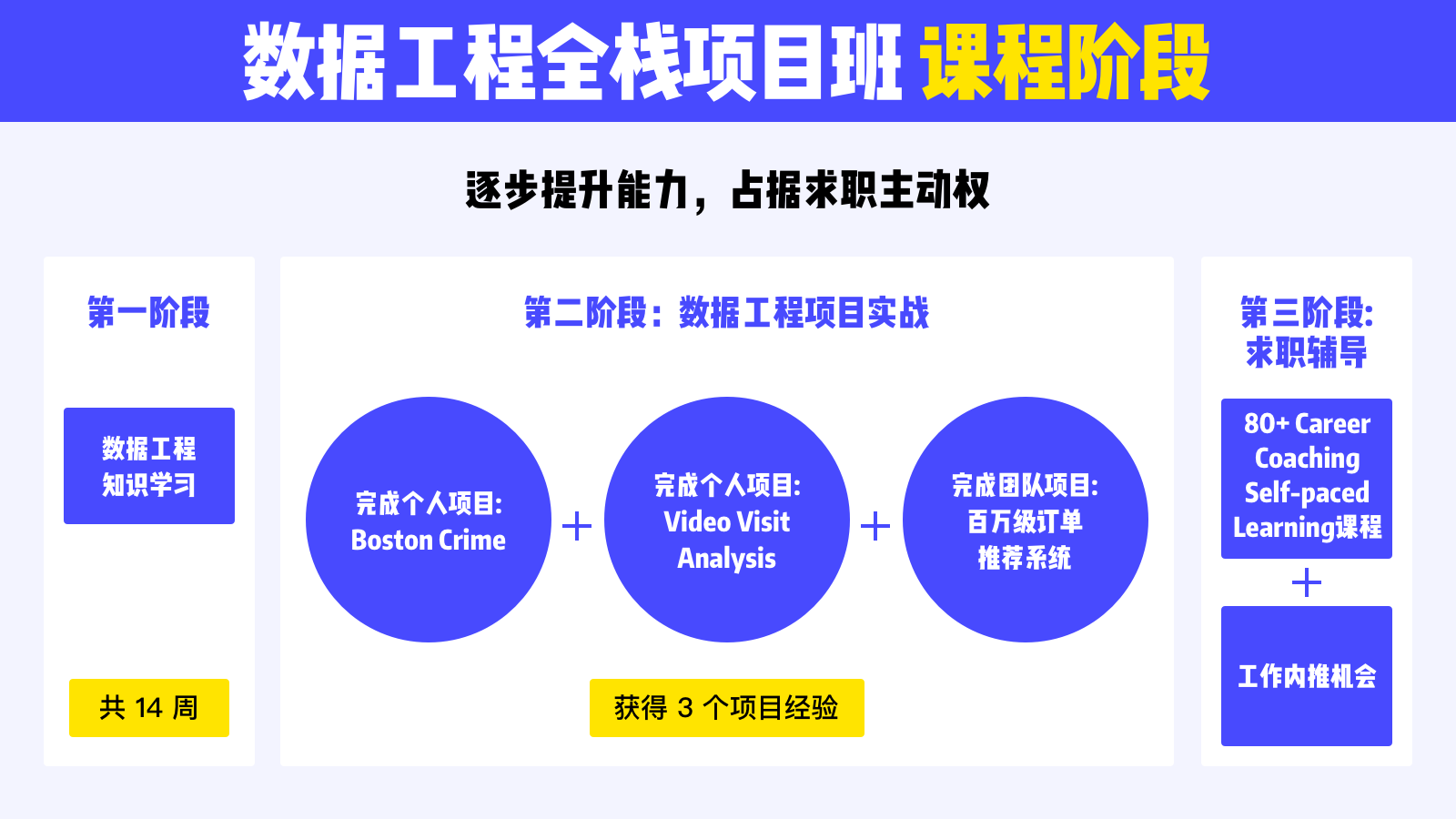

什么是数据工程全栈项目班?

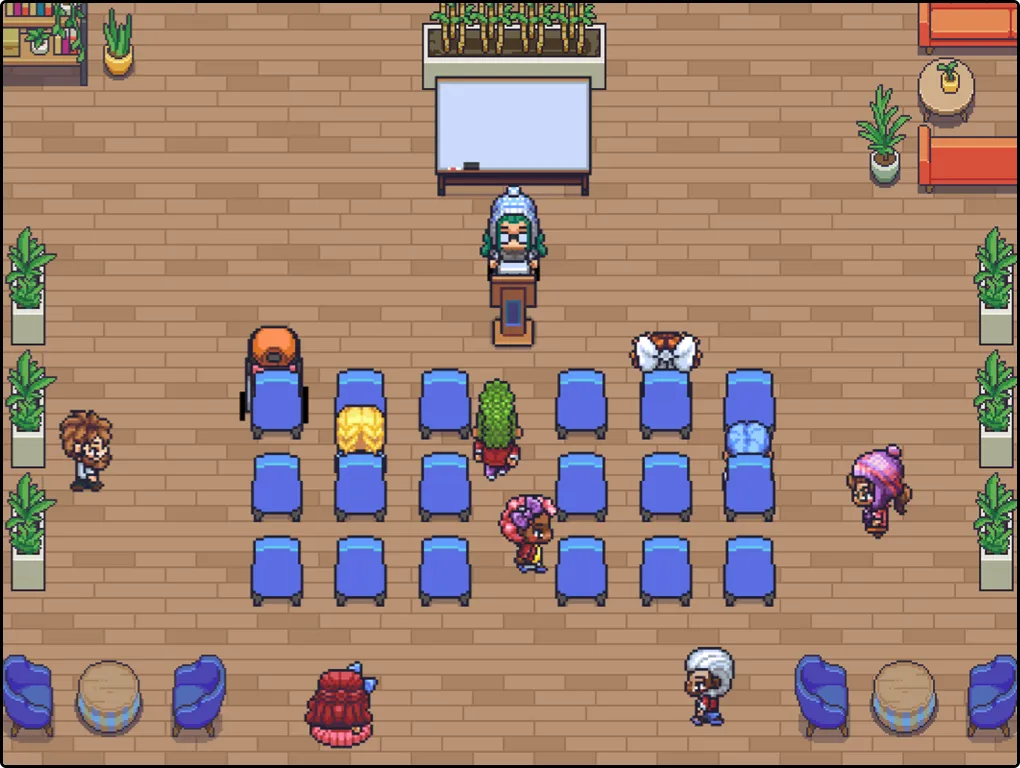

匠人学院的数据工程全栈项目班是全澳首创的大数据培训课程,已经帮助数百位学员拿到Offer,课程由一线大厂导师结合匠人独特的培训5.0模式(直播授课+真实团队项目)来培养出技术过硬,以及有丰富实战经验的数据工程师。并且学生在两年内可以免费重听,享受终身视频免费学习。

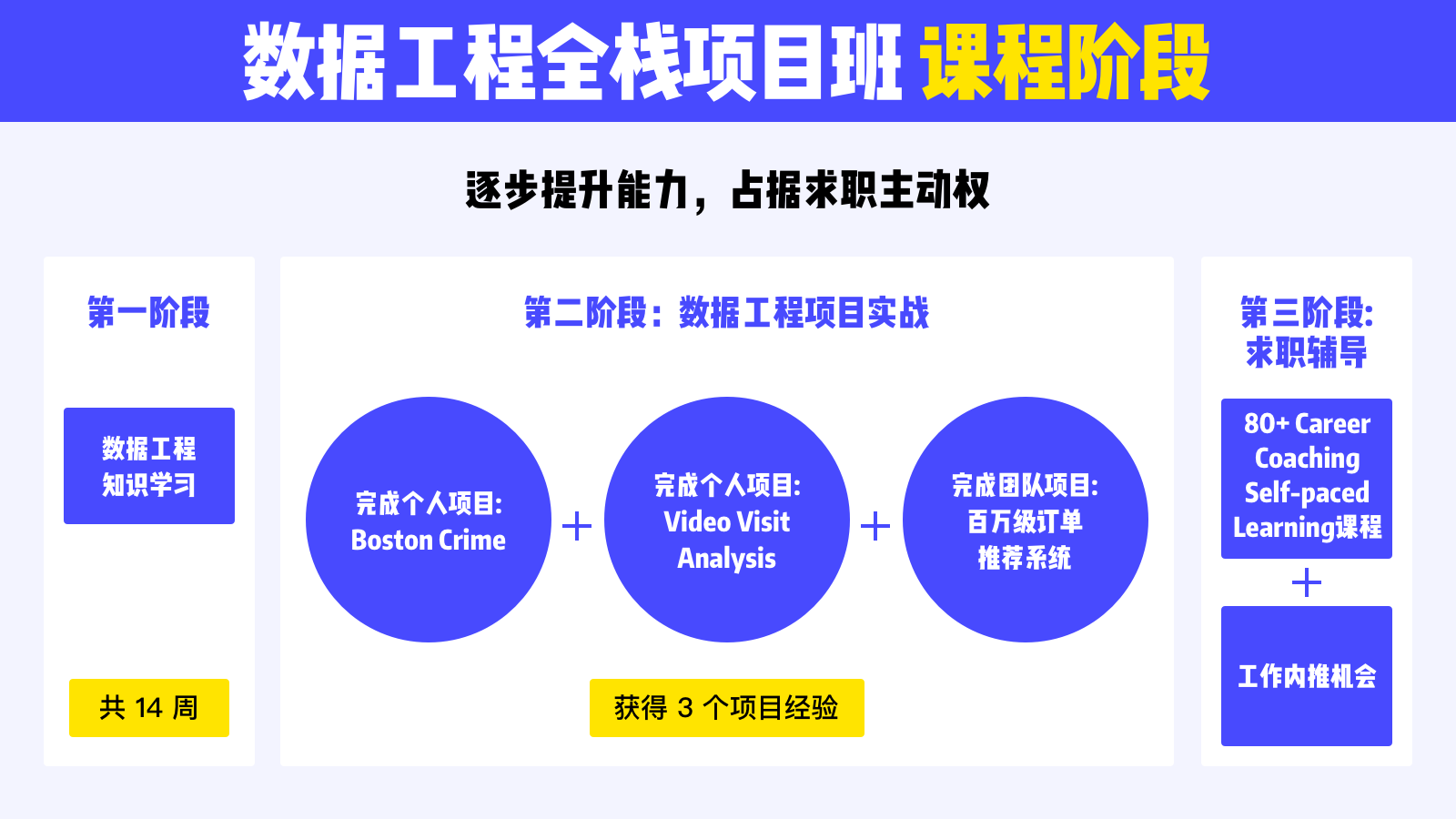

在三个月内,一线大厂导师进行线上授课,为同学答疑解惑,让学生系统地掌握数据工程师的核心技术技能。除此之外,学生还会完成一个独立的个人项目及一个与 DevOps 合作的多角色团队大项目,将所学知识点应用于项目实战中去。

课程会主要分为基础知识学习,数据项目实战以及公司商业项目、简历内推三大阶段来提升学生个人能力,完美模拟真实工作内容及流程。

第一阶段:数据基础知识学习

一线大厂明星导师进行直播授课,系统进行数据工程核心技术的知识讲解,带领学生快速掌握企业级数据仓库搭建和构架,轻松应对公司面试和笔试。

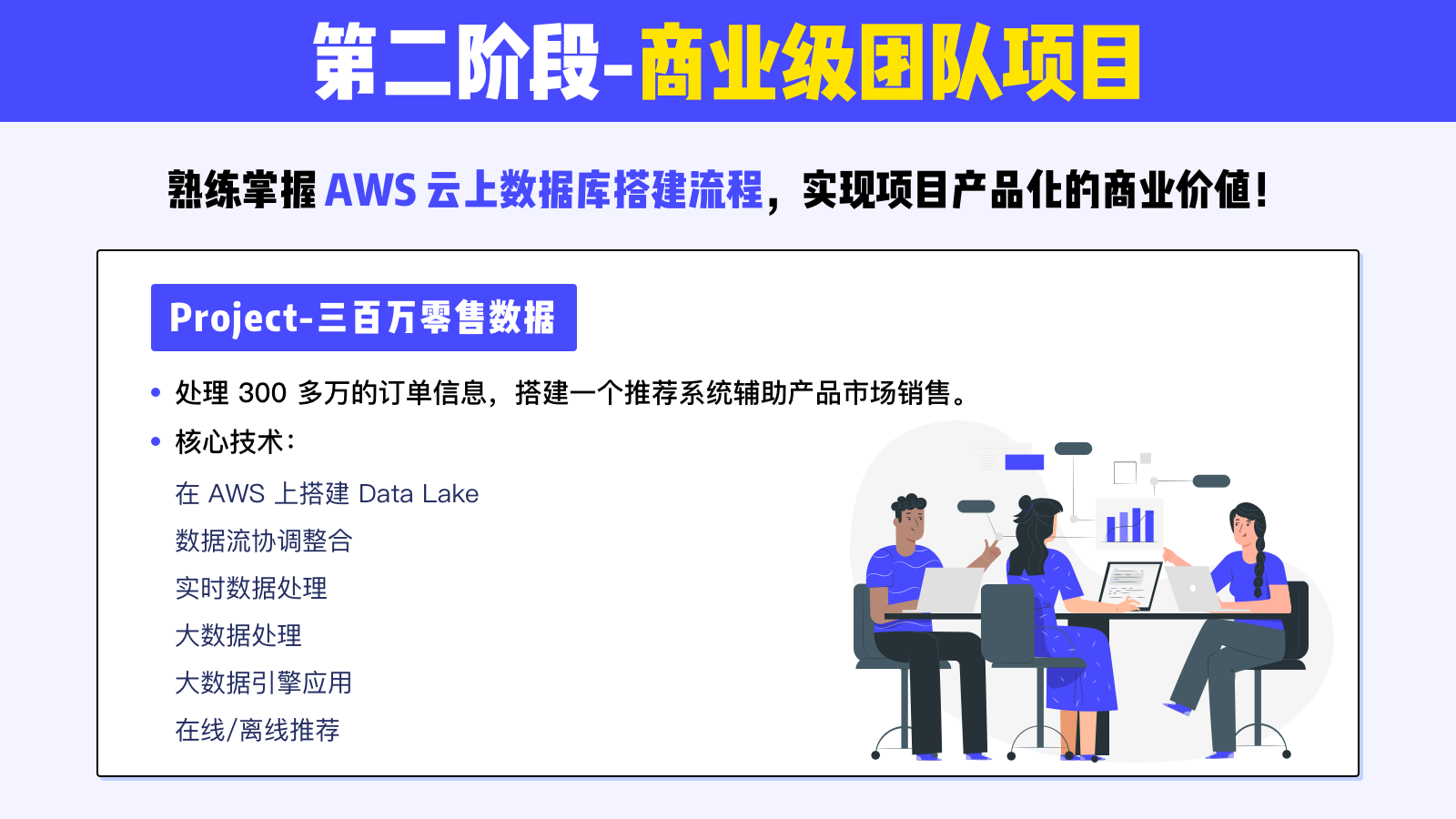

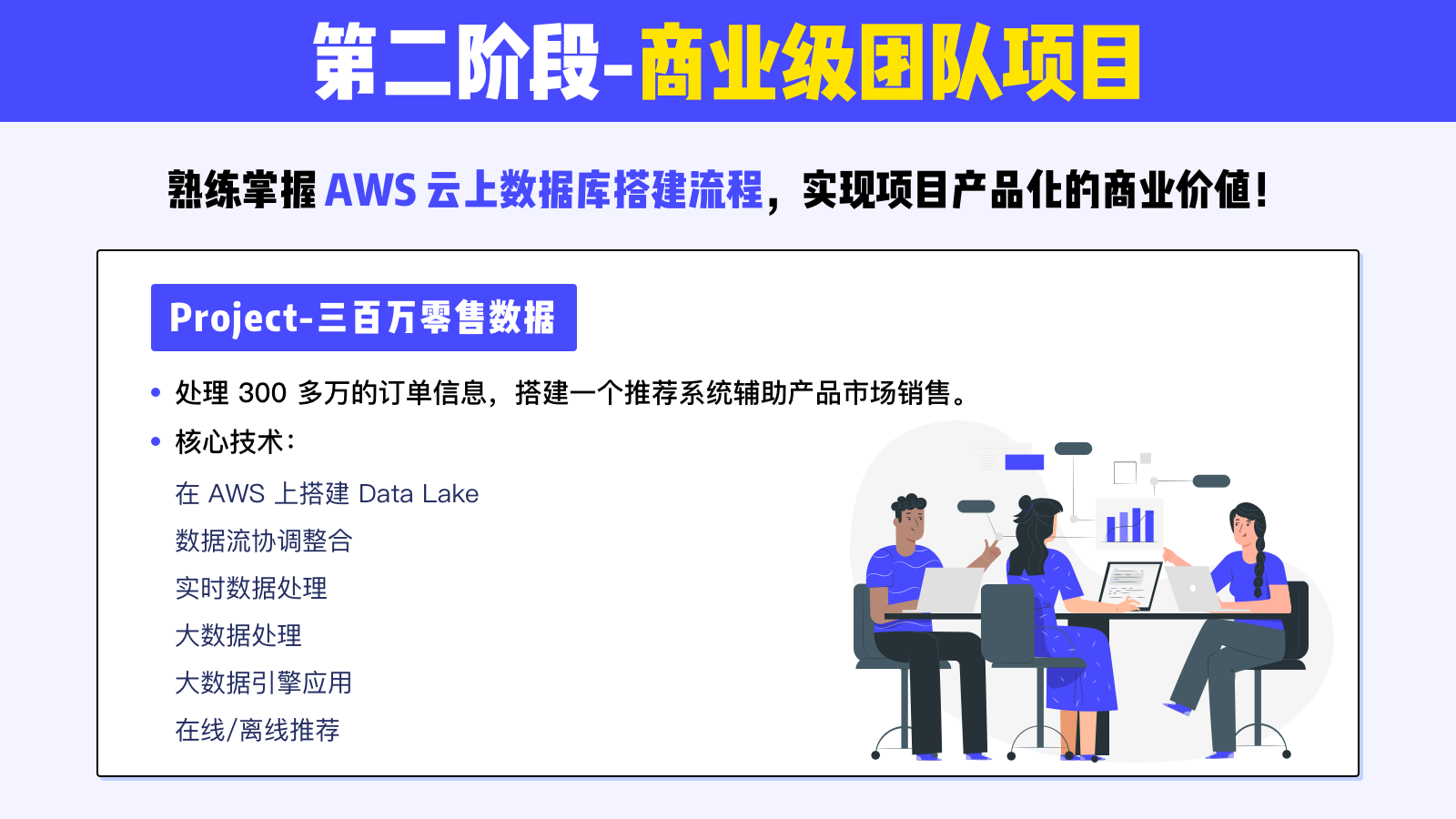

第二阶段:商业级团队项目

有丰富实战经验的技术型人才在市场中更有竞争力。在课程内,学生会完成一个团队大项目,更加熟练掌握 AWS 云上数据库搭建流程,实现项目产品化的商业价值。

第三阶段:简历内推机会

匠人毕业学员的简历,有权优先录入简历内推库。依托匠人长久积累的的企业伙伴和毕业校友、导师的长久合作,这些简历会被优先推荐和匹配合适的岗位,有效缩短求职路径。

第四阶段:IT Career Coaching Self-Pace Learning

80+ Career Coaching课程,从职业规划,简历,面试,谈薪水等多方面提升。

职业规划:澳洲IT行业全景、个性化职业规划、个人品牌打造

找到第一份工作:CV&LinkedIn、面试技巧与策略、行为面试技巧、技术面策略

升职跳槽加薪:System Design面试、薪酬谈判的艺术、升职加薪策略、突破收入天花满

为什么要学习数据工程全栈项目班?

由于目前大学并没有提供系统的培训,一般行业内的数据工程师都是由社会培训,并且企业更偏向于拥有丰富项目经验的数据工程师,就业门槛相对于数据分析师来说更高一些。而我们课程的导师都是来自各个行业,且经验丰富,通过他们的指导,可以快速获取 Offer 直通车的门票。

项目经验丰富,由团队精神的分析师是面试官的首选。匠人多角色团队项目的设计模式更贴合澳洲的真实职场环境,让学生提前熟悉数据工程师的日常工作流程,增加个人竞争力。这是自学没办法媲美的。而且随着匠人培训 5.0 模式的升级,训练营的内容得到越来越多的企业认可。目前已经与德勤,Servian 等公司建立合作关系,能给优秀学员争取更多的内推机会。

数据工程全栈项目班亮点

1.一线大厂明星导师精心打造,进行直播面对面授课

课程导师均来自澳洲一线大厂,具备多年数据岗位从业经验,传授当下招聘市场需要的技术知识以及真实有效的行业经验

2.串联数据工程知识点,有效进行系统学习

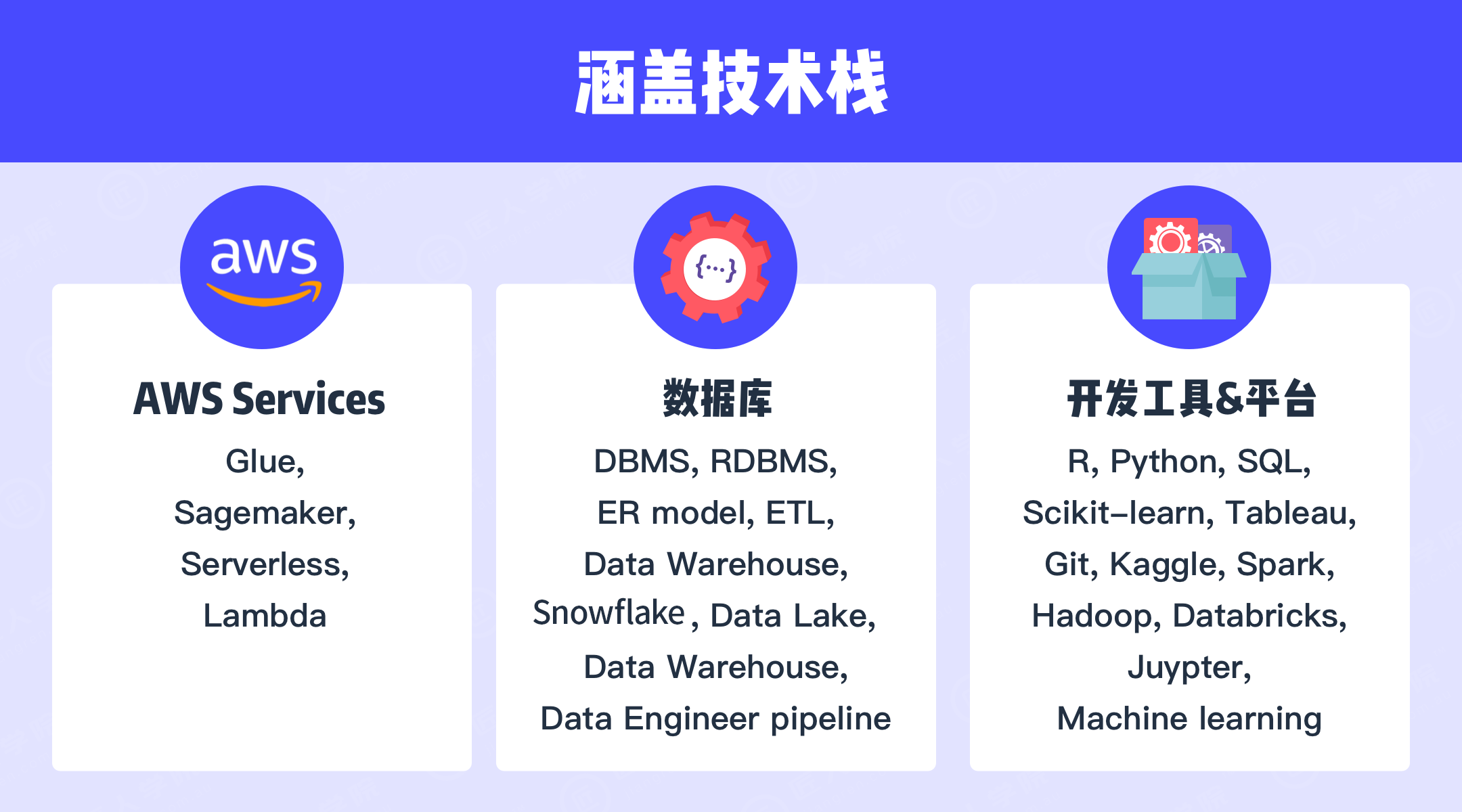

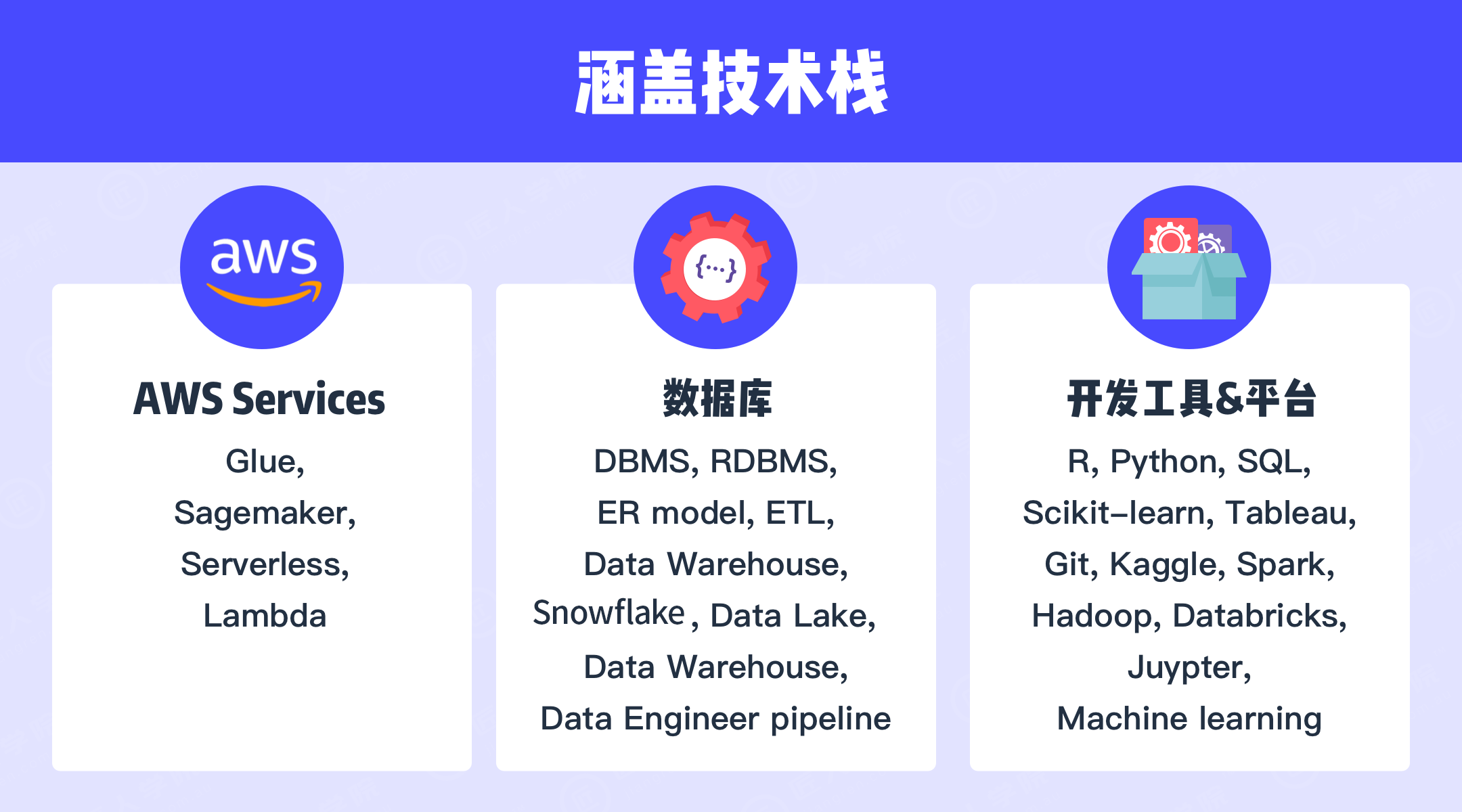

数据工程的核心是如何把不同的工具,和技能串联在一起,不同的接口如何链接,这就需要一个系统化更高维度的学习。课程中涵盖了目前市面上对数据工程师求职所需的所有技能点。除了日常的直播授课外,还会有不定期的 Tutorial 作为指导,帮助你加速理解知识点。课程中包括了如下的知识体系和内容:

数据库基础操作

帮助学生巩固基础知识,主要知识点包括数据库管理系统(DBMS), 数据库查询语言 SQL 以及关系型数据库等。

数据存储

了解大数据的两大存储方式:数据仓库(Data Warehouse)和数据湖(Data Lake)。了解数据探索的几种方法。

大数据

带你了解大数据常用数据结构,并结合谷歌云服务 GCP 学习云端处理大数据的基本操作和可用服务。

数据建模&机器学习

掌握回归、支持向量机 SVM、决策树等几种机器学习算法,了解真实工作中分析数据的流程,从需求分析、数据建模到获取结果。

Python 数据分析

学习使用 Python 进行数据分析,学习 Python 相关模块。

数据可视化

学习利用 Tableau 可视化数据结果,并通过十多个不同案例掌握数据可视化的具体操作。

AWS 部分

学习使用亚马逊云服务 AWS 的服务和功能,上手云端搭建数据工程,最实际、最有竞争力的行业必备技能

3.简历内推库

让学员“不仅仅是获得实习,更成为工作 offer 收割机”

简历内推库是一个特设的、专为我们的学员打造的数字化简历存储平台。在这里,每位学员的简历都经过专业导师的审核与优化,确保其准确、专业且符合行业标准。

4.优秀同学内推机会

匠人受到许多企业的认可,我们会根据学生项目完成质量及项目 Tutor 对学生的评价,对项目中表现优秀的同学进行优先内推。

数据工程全栈班和别的课程对比

学员真实 Offer 展示

自数据工程全栈班开班以来,有超 200+ 同学进入澳洲各大公司如 afterpay,Mecca 和 Thoughtworks 等工作。

课程适合人群

本课程专为 IT/CS/DS/IS 专业的毕业生和在校生设计,帮助学员跃升为掌握职场技能的数据工程师和数据科学家。

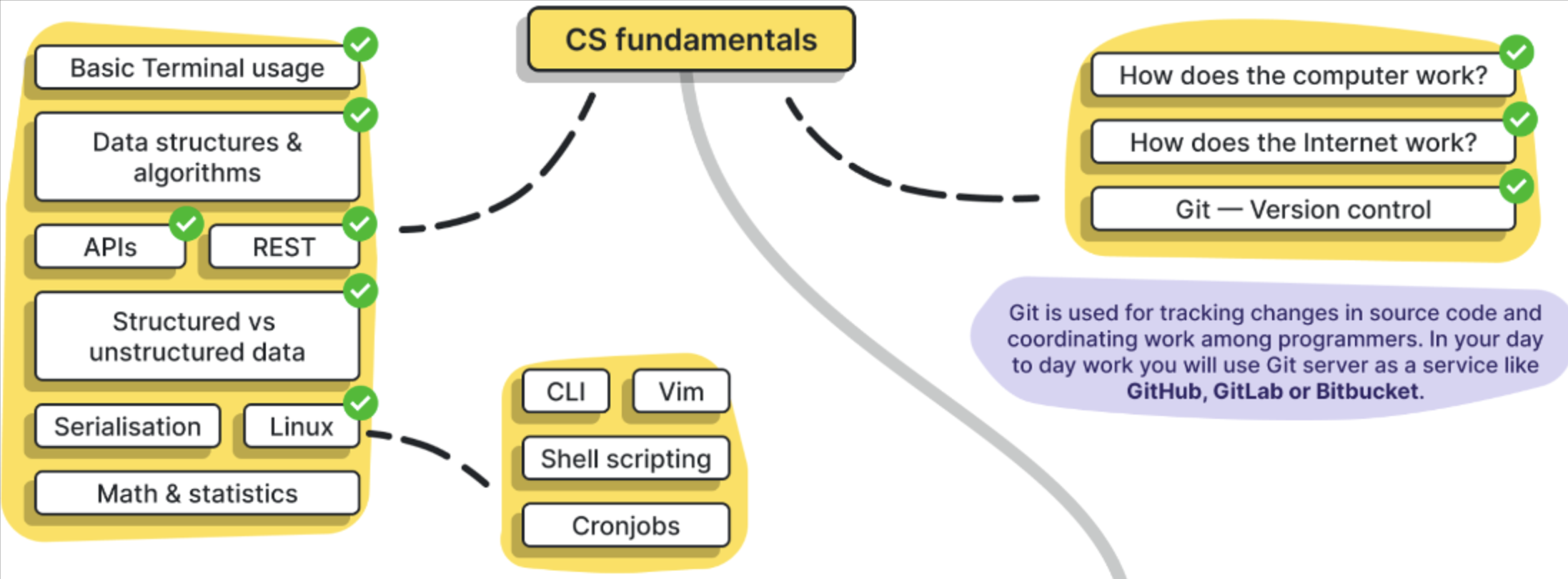

你需要掌握:

课程不适合

完全不了解 Python 的基础知识

没有 SQL 基础知识

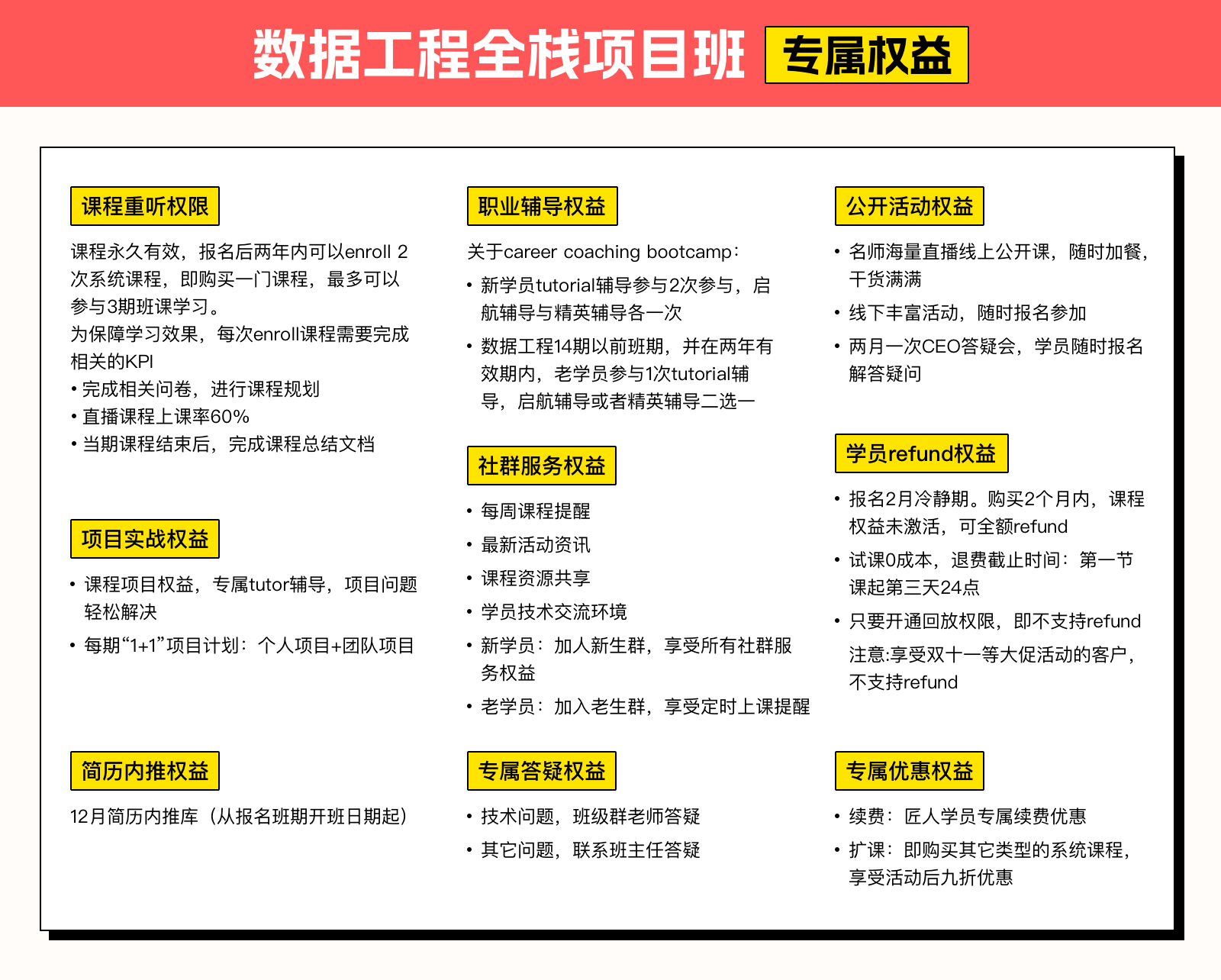

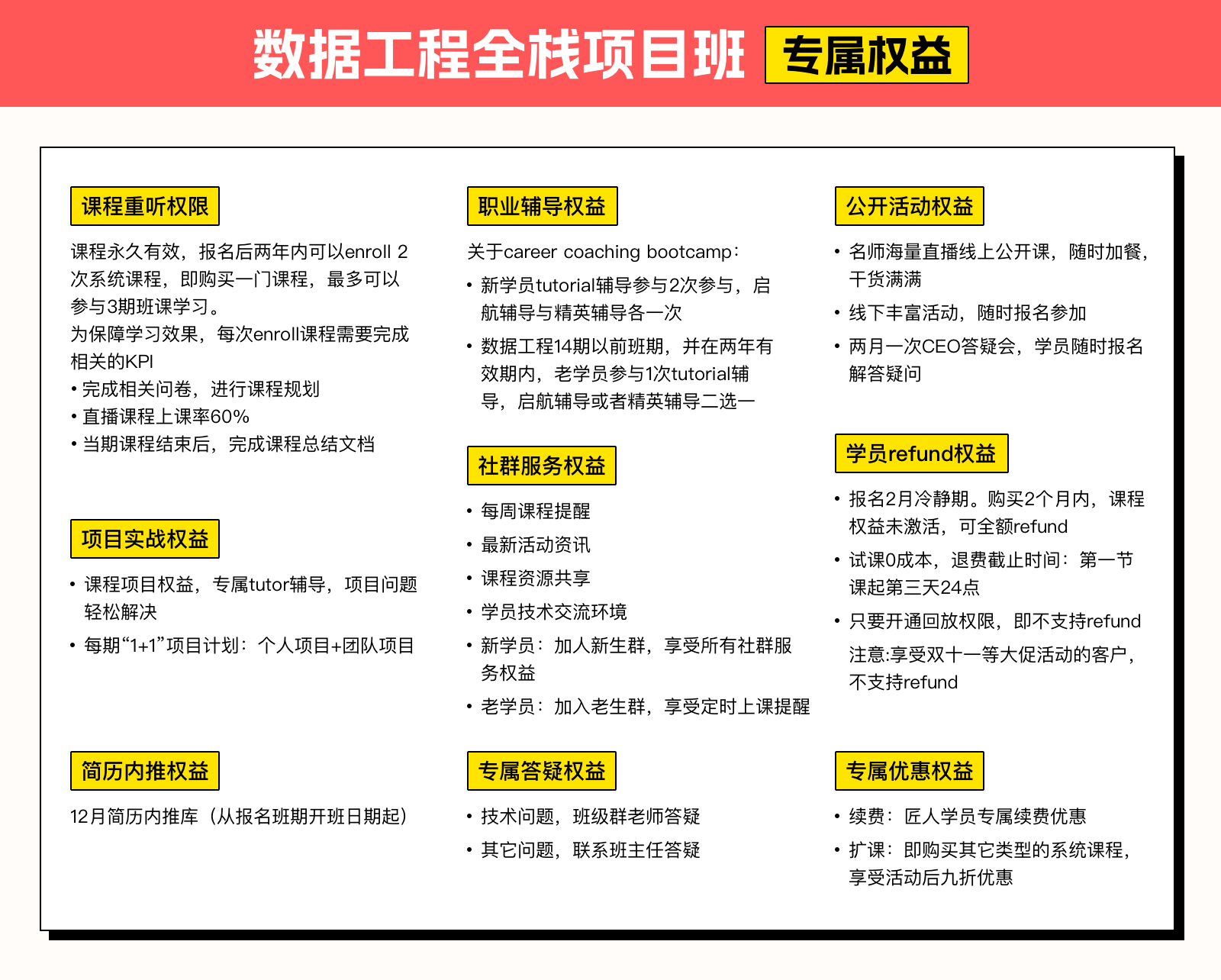

学员权益大盘点,属于匠人学员的专属礼遇

概念界定

⚠️以下权益仅限购买课程本人使用,禁止售卖和转让,一经发现封号处理