Claude Code + GLM 4.6 配置

Claude Code + GLM 4.6 保姆级配置教程

放假在家,原本想继续用 Claude Code 写代码,但遇到一个现实问题: 公司电脑有稳定的美国 IP,可以正常用 Claude Code; 个人电脑、家里网络因为网络环境问题,Claude Code 根本登不上(Claude Code 是封禁最严的工具,比 claude 客户端还严)。

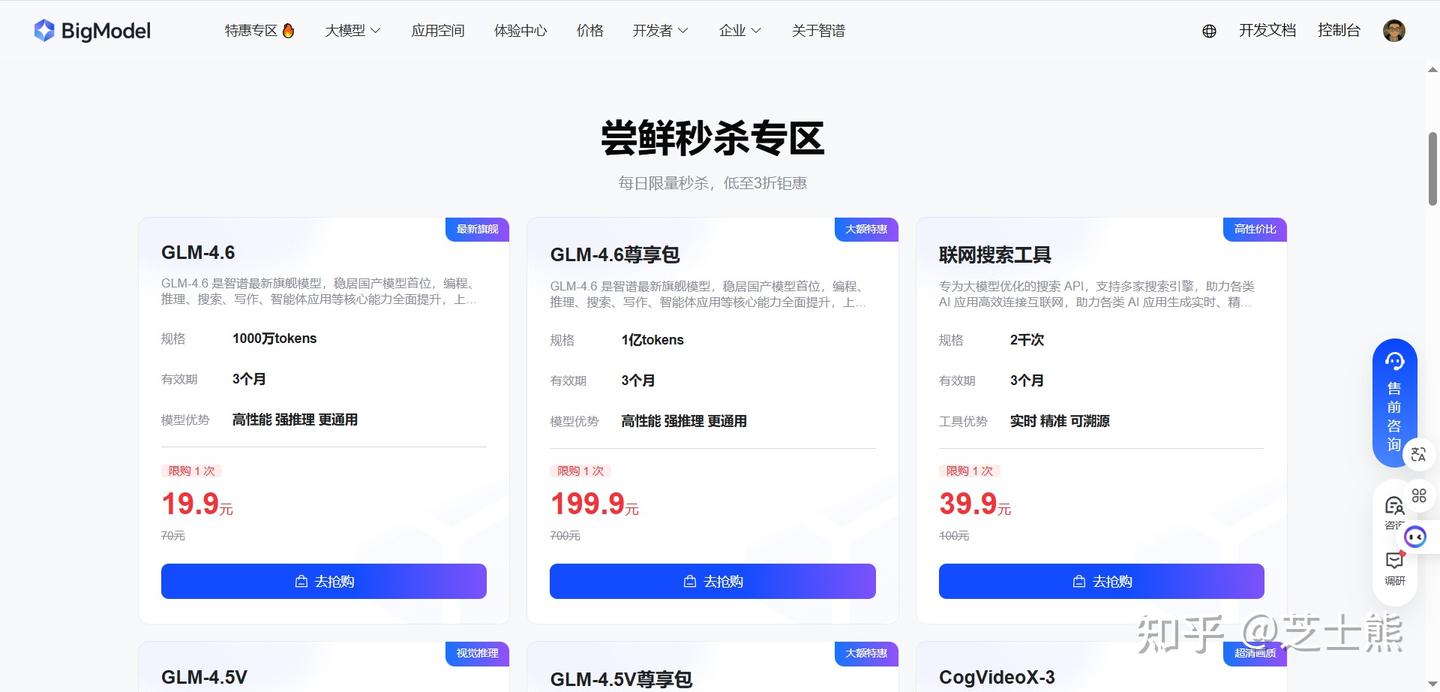

正巧智谱的 GLM 刚升级到 4.6,还推出了 GLM Coding 套餐(价格很划算)。于是我临时决定用 GLM-4.6 来替代 Claude code 的 claude 模型。

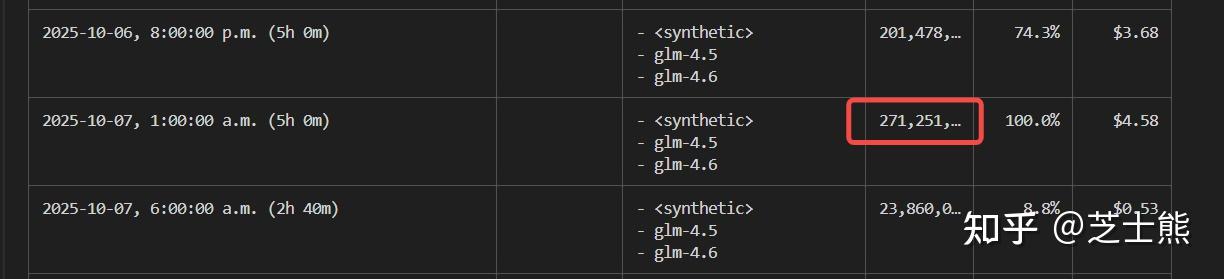

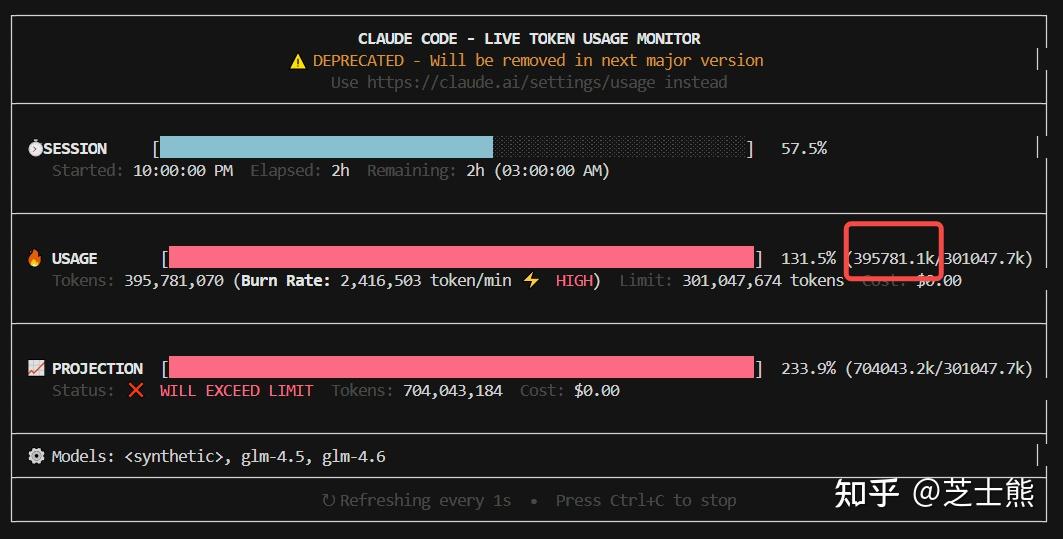

通过正确的使用方式,可以让 claude code 7 x 24 充分工作。安装完之后,我查看了下用量,按照我自己的用法,5 小时可以消耗 2.7 亿 tokens(还没触发限制),基本上可以说 2 小时能回一个月价格的本了。。对比按 tokens 付费的官网价(200 元/1 亿 tokens)。

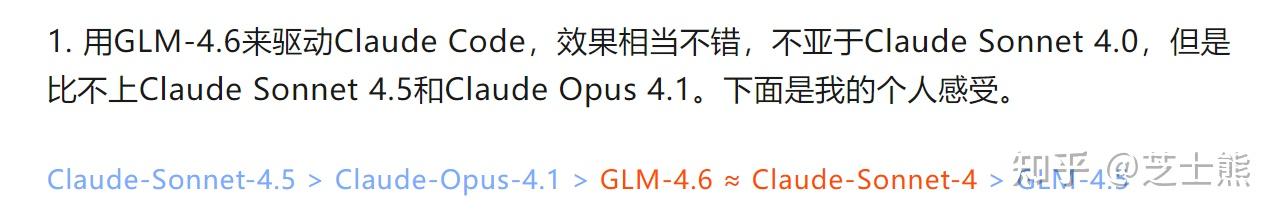

结果体验下来还不错:

- Claude Code 的 功能、MCP 插件 生态都能用;

- 效果上,根据 claude code 大神刘小排的评测,能到 claude 4

都是个人体感,还得自己用了看。我自己感觉也是不错的。

都是个人体感,还得自己用了看。我自己感觉也是不错的。

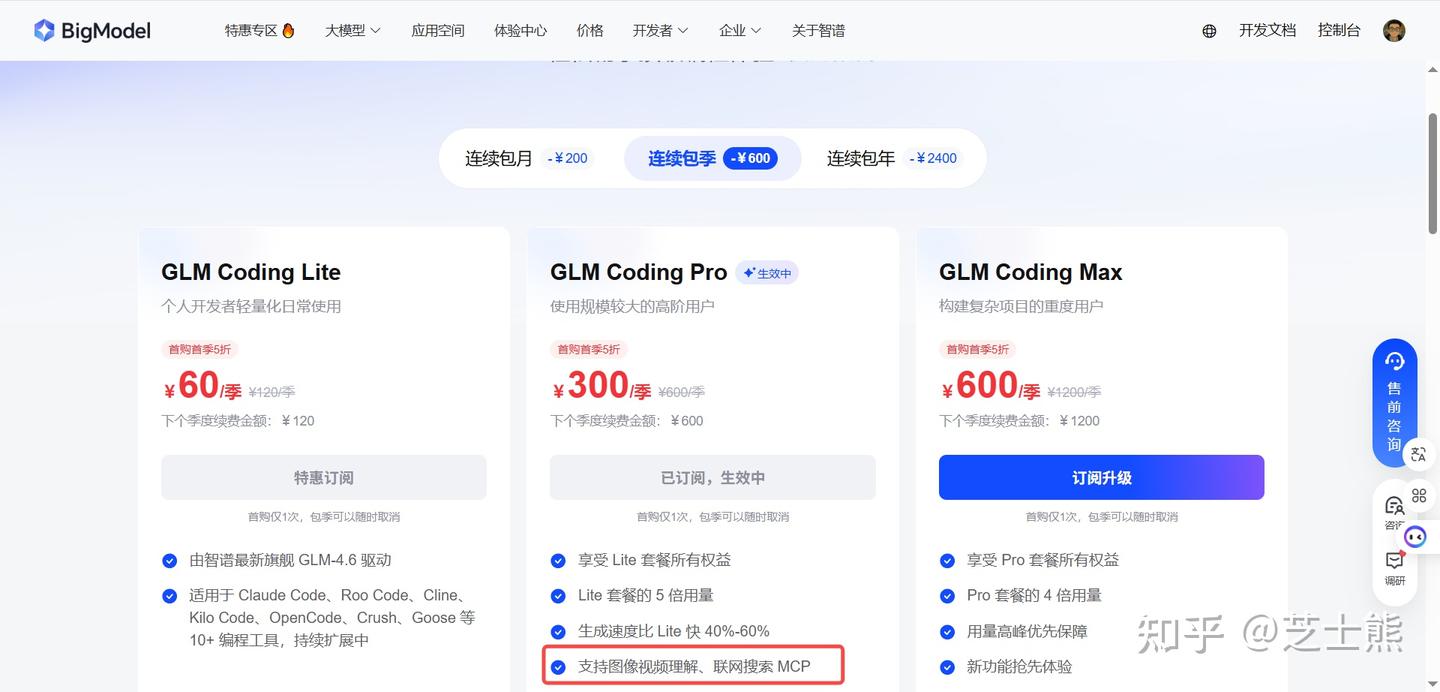

- GLM Coding 套餐的价格相比 Claude API 也实惠很多,pro 版一个月才 100 块,最便宜的版本每个月 20 元(不推荐)。 据说,GLM 的 100RMB 限额,是 claude code 100 美元限额的三倍,我没验证过。

所以分享一下 Claude Code + GLM-4.6 的完整配置方法。

准备工作

- ** 注册智谱 AI 开放平台账号** 链接:智谱 AI 开放平台

这是我的裂变推荐链接,还能再减 30 块,所以一个季度是 270 块。 btw,虽然套餐可以升级,但只有裂变首单才有 10%折扣。我季付往年付升的时候发现享受不到 10%了,所以想用多久就直接买那个周期的吧。

- Lite:5 小时约 120 次调用

- Pro:5 小时约 600 次调用(推荐)

- Max:5 小时约 2400 次调用

这些是“预估次数”,会随任务复杂度、是否自动批准等变化。

** 建议至少要买 PRO。** 一方面是 Lite 限频不够用,而 PRO 在单开一个 terminal 全程跑 10 个并发的 task agent,应该将将够用(我的使用经验)。如果多开 terminal+task agent 可能 max 才够。

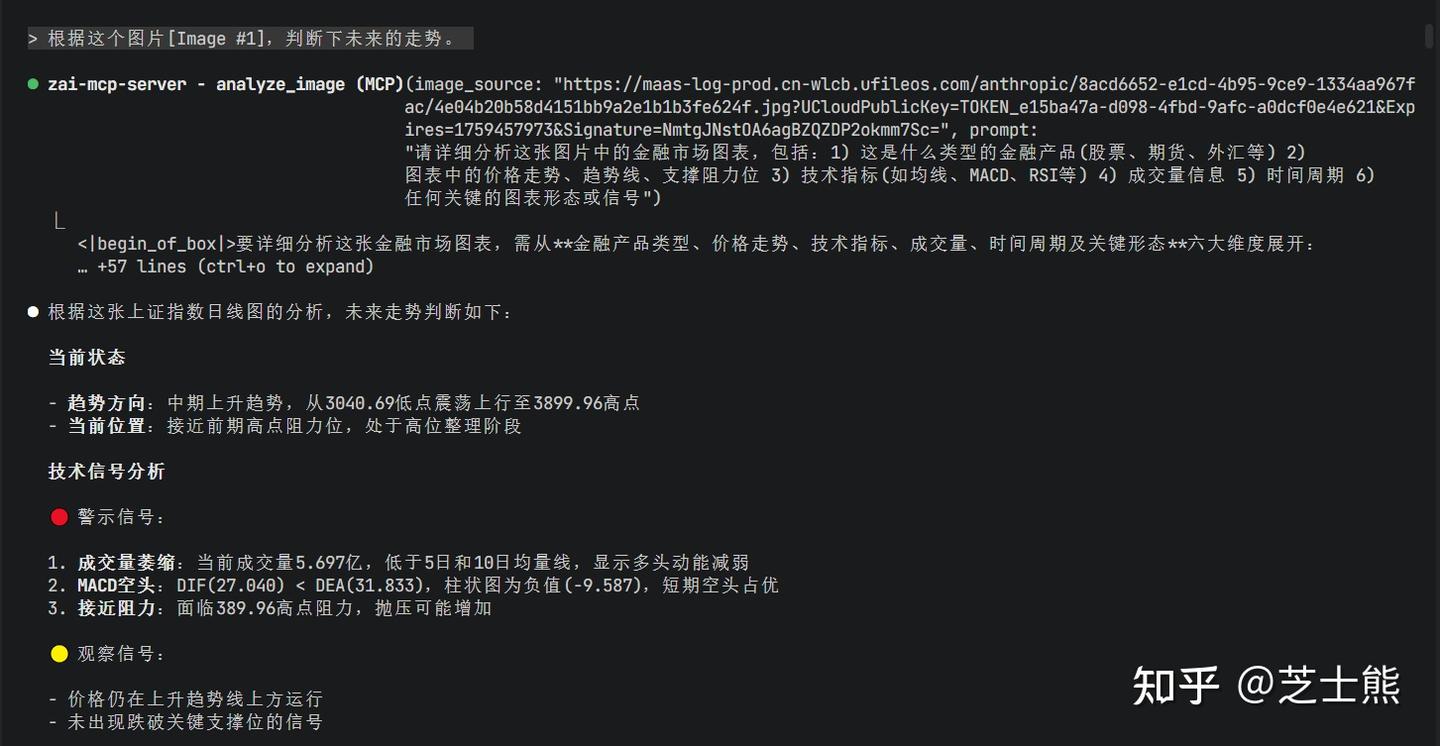

另一方面,GLM-4.6 不是一个原生的多模态模型,加上 GLM 的图片和视频理解的 MCP 可以补足。

另外,如果登不上 claude code 的 anthropic 账号,那么搜索也没办法用,而 web search 是缺少信息时必备的一个技能。需要用 GLM 的搜索 MCP 补足。详见Claude Code+GLM 4.6 的一些必要配置

Claude Code 配置环境变量

找到 Claude Code 的配置文件(通常在~/.claude/settings.json,Windows 在C:\Users\<用户名>\.claude\settings.json)。加入以下内容:

{

"env": {

"ANTHROPIC_AUTH_TOKEN": "yourkey here",

"API_TIMEOUT_MS": "3000000",

"ANTHROPIC_BASE_URL": "https://open.bigmodel.cn/api/anthropic",

"MCP_TOOL_TIMEOUT": "30000"

},

"permissions": {

"defaultMode": "bypassPermissions"

},

"alwaysThinkingEnabled": false

}

除了配置 env 之外,我另外加了 「defaultMode」: 「bypassPermissions」。因为使用 claude code 的原因就是希望 claude code 帮我自动完成长周任务。我是绝对不希望

运行一下:

果然成功了

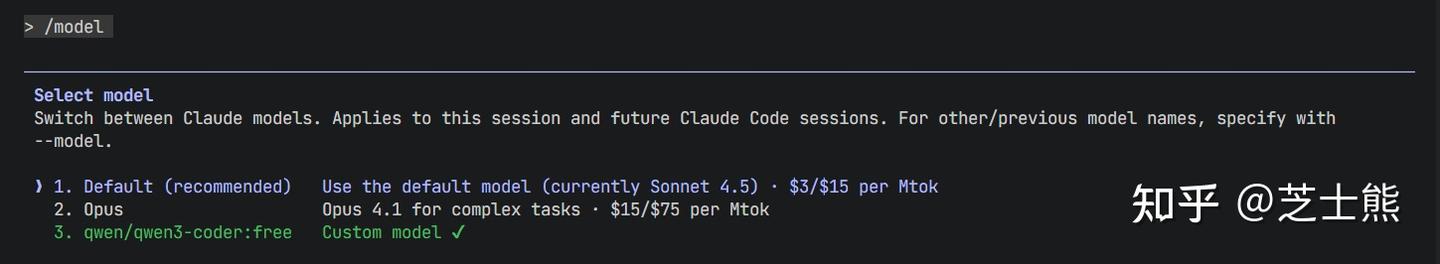

注意一点:

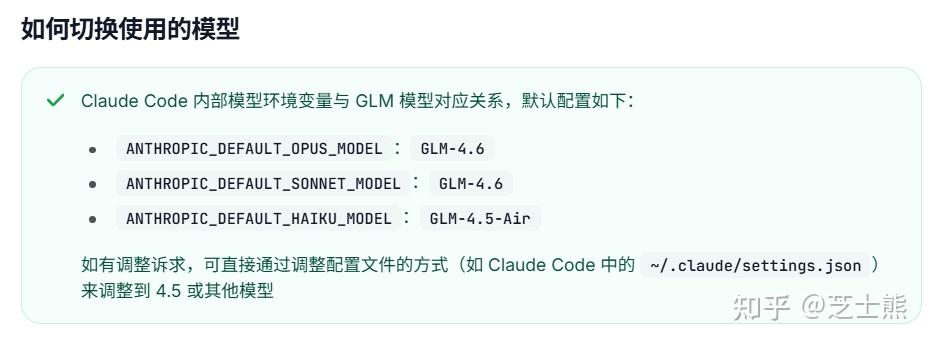

需要把模型切换到 default。在 claude code 看来,还是在用 sonnet。但我们把 url 改成 glm 的链接了。

验证 GLM4.6 使用成功

用一条 PowerShell 调 GLM 的Anthropic 兼容接口,直接回显实际模型

这会复用你已配置的

ANTHROPIC_AUTH_TOKEN和ANTHROPIC_BASE_URL。

$BASE = $env:ANTHROPIC_BASE_URL

$KEY = $env:ANTHROPIC_AUTH_TOKEN

$headers = @{

"x-api-key" = $KEY # 大多数兼容端点支持 x-api-key

"Authorization" = "Bearer $KEY" # 有些也支持 Bearer;两者都更稳

"anthropic-version" = "2023-06-01"

"Content-Type" = "application/json"

}

$body = @{

model = "default" # 就用你现在的 default 看它被路由到谁

max_tokens = 1

messages = @(

@{

role = "user"

content = @(

@{ type = "text"; text = "只返回你当前的模型 ID" }

)

}

)

} | ConvertTo-Json -Depth 8

$r = Invoke-RestMethod -Method Post -Uri "$BASE/v1/messages" -Headers $headers -Body $body

$r.model # ← 这里会打印实际模型,比如 glm-4.5 或 glm-4.6

- 输出如果是

glm-4.5,那就是 4.5;如果是glm-4.6,就是 4.6。

看起来 GLM 4.6 调用成功了。

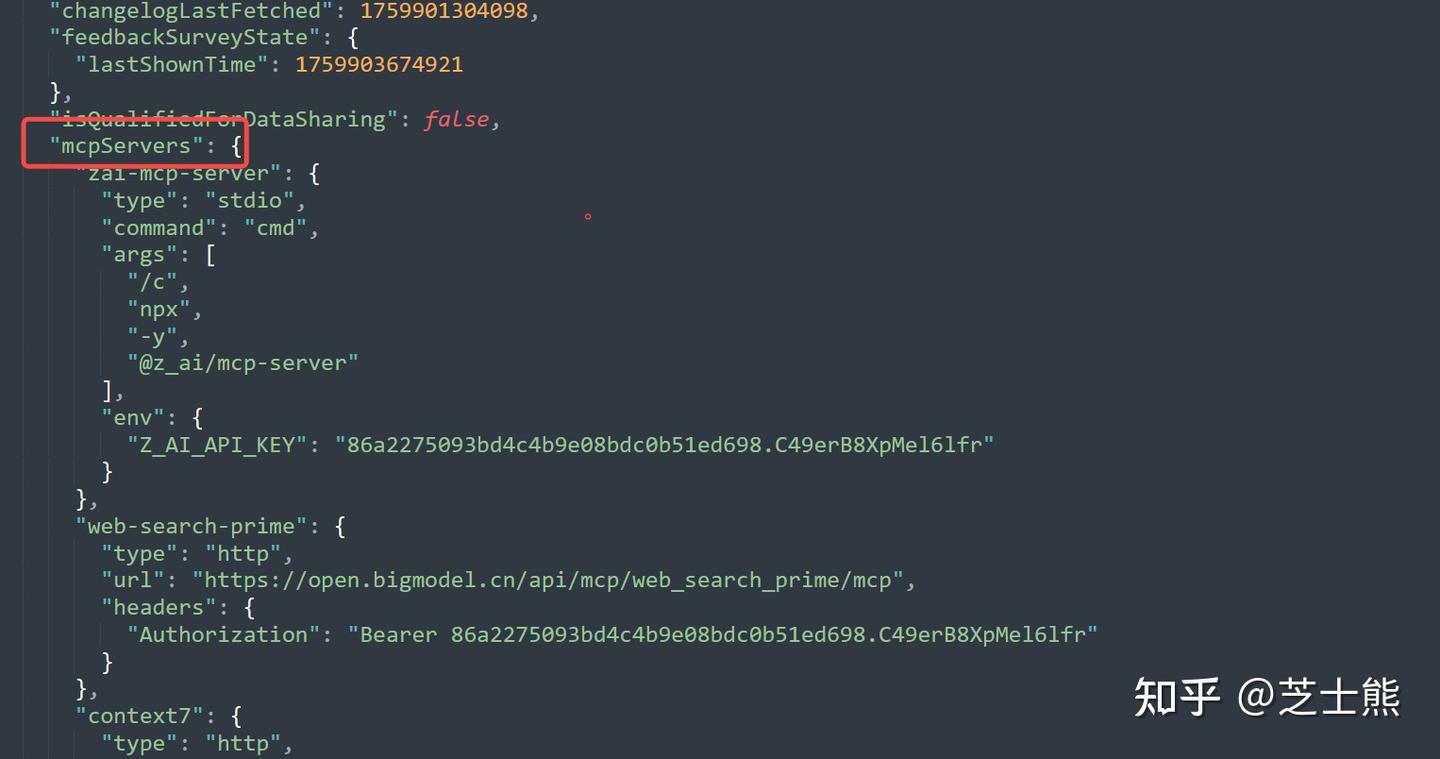

MCP 补充

启用联网搜索 MCP

在命令行下输入这一段

claude mcp add-json web-search-prime '{"type":"http", "url":"https://open.bigmodel.cn/api/mcp/web_search_prime/mcp","headers":{"Authorization":"Bearer <你的 GLM API Key>"}}' --scope user

GLM 的 Pro 套餐自带这个联网搜索 MCP,配置好后在 Claude Code 里可以直接调用。

注意在使用 claude mcp add 命令的时候,后面一定要加 --scope user。才能全局安装。自己用的时候吃了一些亏才发现。当然如果是直接去 json 文件里改,就没这些问题。

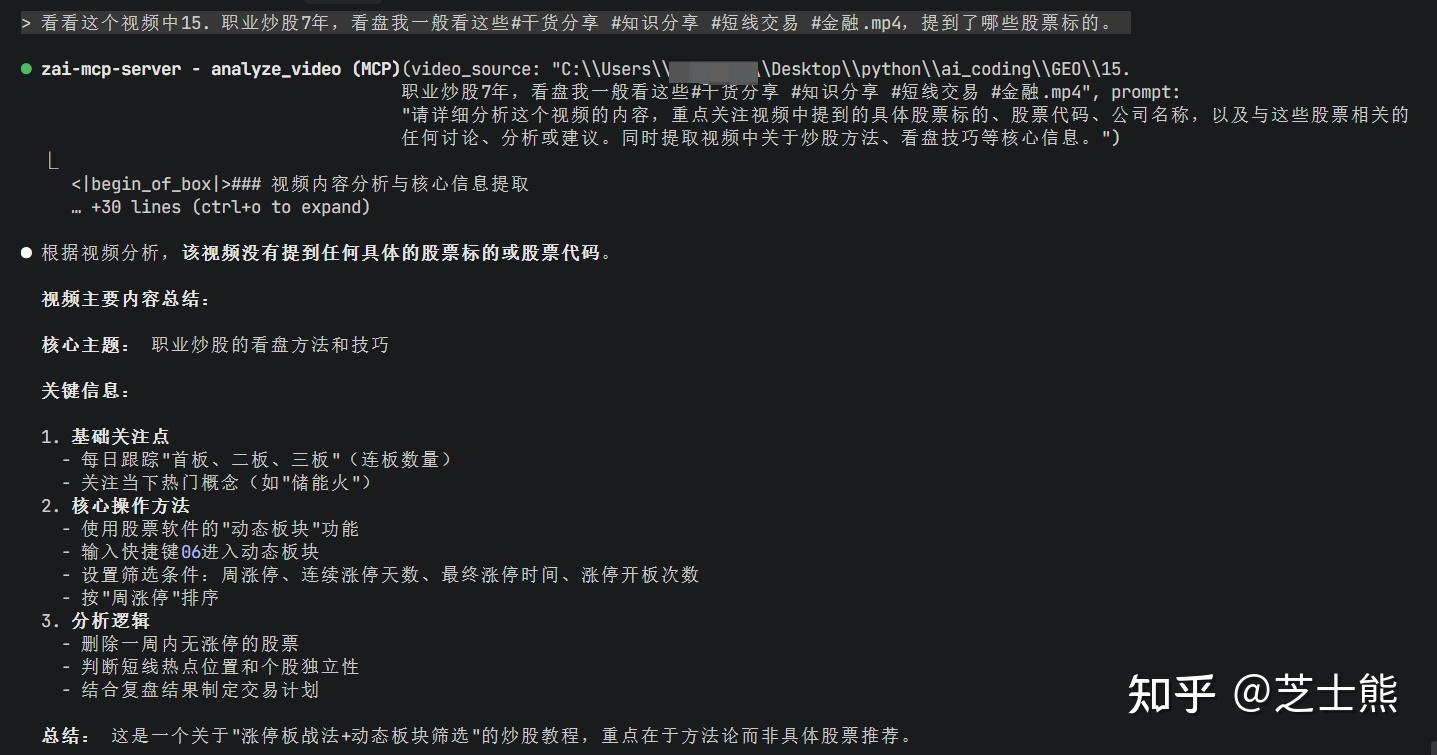

启用图像/视频理解 MCP

同样,在命令行下输入这一段

claude mcp add-json zai-mcp-server '{"type":"stdio","command":"cmd","args":["/c","npx","-y","@z_ai/mcp-server"],"env":{"Z_AI_API_KEY":"<你的 GLM API Key>"}}' --scope user

这个 MCP 支持图像 + 视频的解析。安装后,Claude Code 就能在对话里直接读取文件里的图片或视频帧。

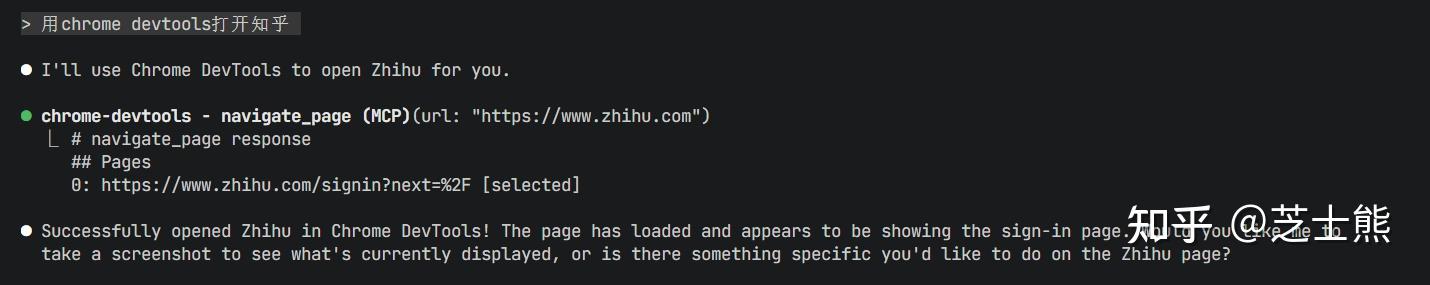

浏览器操作的 mcp 也一定是要装的。

过去我会推荐使用 browsermcp,因为可以记录登录信息。

既然 chrome 官方出了 chrome devtools,那么当然是用官方的。而且同样可以记录登录信息。

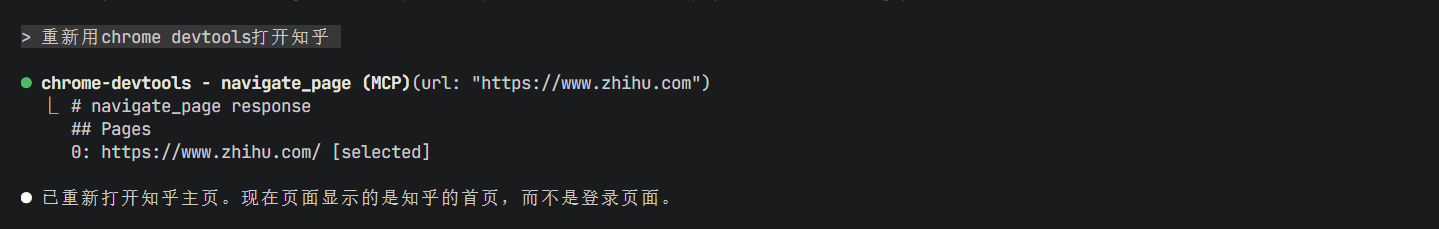

https://www.zhihu.com/account/scan/login/YjVlZWExMmItMDcy?/api/login/qrcode (二维码自动识别)

登录、关闭 chrome,再次打开:

markitdown

一个微软开发的,将 pdf 等文件类型变成 llm 可读文件的工具。

有 MCP,有需要的可以安装,不详细讲了。

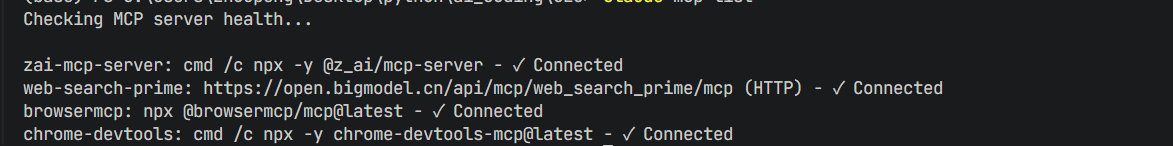

验证 mcp 安装成功

查看一下我安装的 mcpe:

claude mcp list

使用小技巧:

- 如果你在跑自动化任务,可以定期刷一下 chromedevtools 自动打开了哪些网页,把他们都登录一遍。虽然 chromedevtools 可以记录登录信息,但不是你经常使用的 profile,而是新起了一个。

- 另外,模型自动运行的时候,经常也会打开 google 等外网,可能和训练数据有关。记得打开科学。或者#加入 memory,让他多搜国内网站。

用量查看

安装

全局安装

npm install -g ccusage

常用命令

ccusage # = ccusage daily(默认日汇总)

ccusage daily --since 20241201 --until 20241231

ccusage weekly # 周汇总

ccusage monthly # 月汇总

ccusage session # 按会话(对话)查看

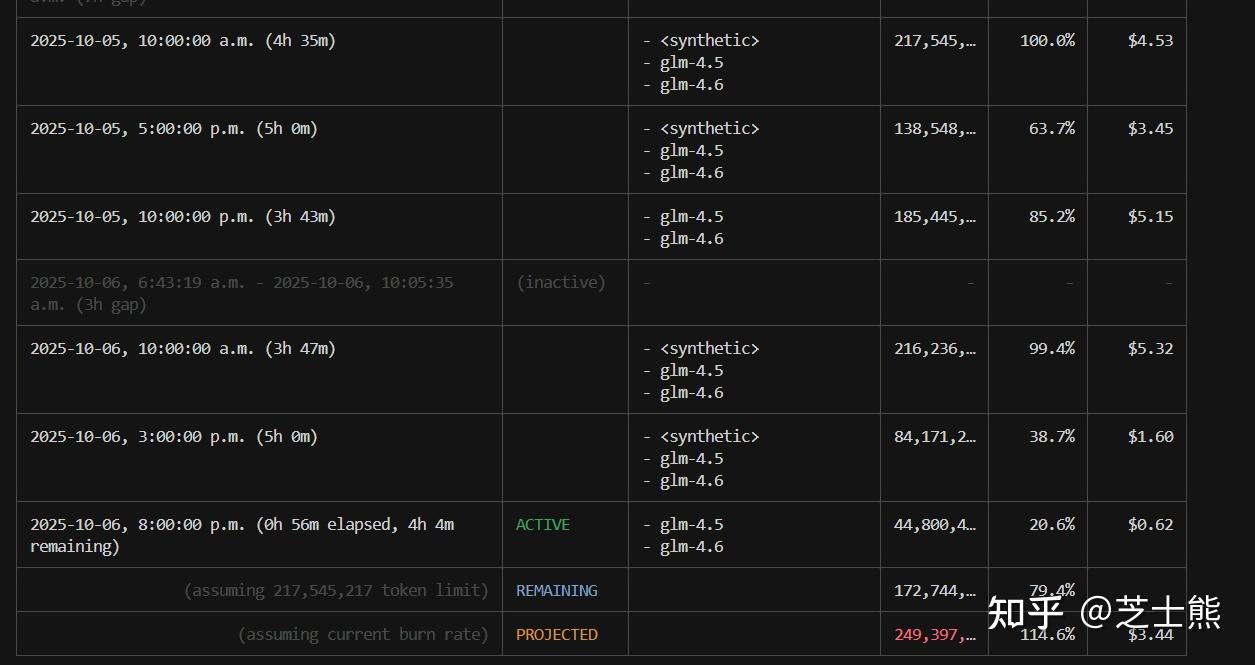

ccusage blocks # 按 5 小时计费窗查看(含 Active/预测等)

ccusage blocks --active # 只看当前活跃窗口

ccusage blocks --recent # 近几天窗口

ccusage daily --breakdown # 分模型拆解

ccusage monthly --json > usage.json # 导出 JSON 做二次分析

其中 ccusage blocks 可以看 5 小时窗口,还能估算剩余额度。

我使用下来 5 小时最高可以到 2 亿多 tokens

我使用下来 5 小时最高可以到 2 亿多 tokens

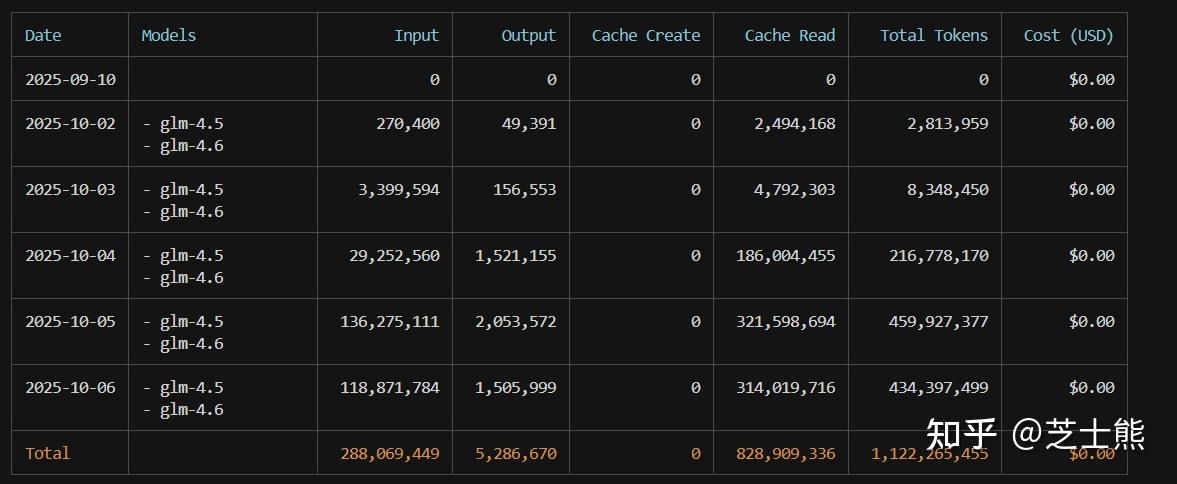

ccusage daily 可以查看按天用量。

我平均每天可以用掉 3 亿多 tokens。

我平均每天可以用掉 3 亿多 tokens。

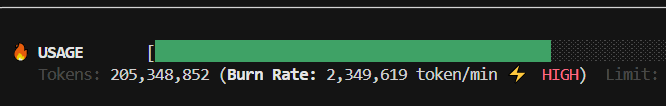

当然最推荐的是

ccusage blocks --live

可以每 1s 实时刷新,享受观看 API Token 消耗的快乐。有兴趣的可以看看我另一篇,如何让 Claude Code 稳定长跑

补充:并发和速率

官网描述并发限制如下(充值可以加并发)。

近期官方把 glm4.5 的并发也砍半了,从 20 降到了 10。看起来智谱确实薅了一大波付费用户,资源没那么充裕了。不过加起来 15 的并发也够用。不过,这个并发限制并不是必然命中,前一阵程序员节的时候总是命中,但最近 10 路并发似乎也不触发。还是看 glm 资源情况吧。 官方默认的降级策略,是降到 glm-4.5-air。建议还是手工改下配置,改到 glm4.5 吧。谁要用性价比模型啊是吧。 另外,如果你在凌晨 4 点编程,你可能能感受到极限速度。。。

不过这个并发限制我测下来也是偶发。周末的时候似乎 GLM4.6 并发 20 路也没触发。也可能是 GLM 慢慢在把 4.5 的资源挪给 4.6,或者是只在峰谷的限制不一样。

工作日测试,确实是严格 5 路并发,多一路就 error。

不够用的可以用 GLM4.5,给了 20 路并发,这就肯定够用了。4.5 和 4.6 发布时间离得不远,效果还可以。而且我看社区里也有人说 4.5 比 4.6 好的,也是垂直场景主观看法了。

** 如果你确实有很高的并行要求,你可以这么邪修:**

claude --model glm-4.5

单开一个使用 glm 4.5 的 terminal,让他 20 路并行。这样你总共就可以获得 10(4.6)+20(4.5)的并行体验。实测有效。

晒一下我测试的消耗极限:235 万 tokens 每分钟,换算下来就是 7 亿 tokens 每 5 小时。确实是在 burn 了。

补充:5 小时限量

终于测出来了,命中了 5 小时 limit,不容易啊。按照吴恩达的说法,ai coding 真的是 exhausted。

429 {"type":"error","error":{"type":"1308","message":"Usage limit reached for 5 hour. Your limit will reset at 2025-10-18 03:03:23"}

大概 4 亿 tokens 吧。我用的是 pro 订阅。如果是 max,按照官网说法,应该还要再乘上 4 倍。

补充:GLM 的空间感

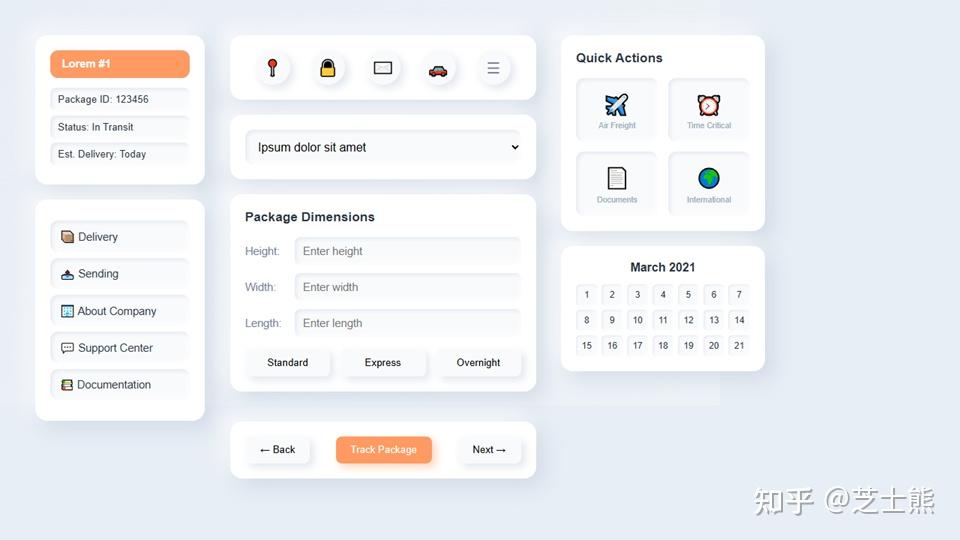

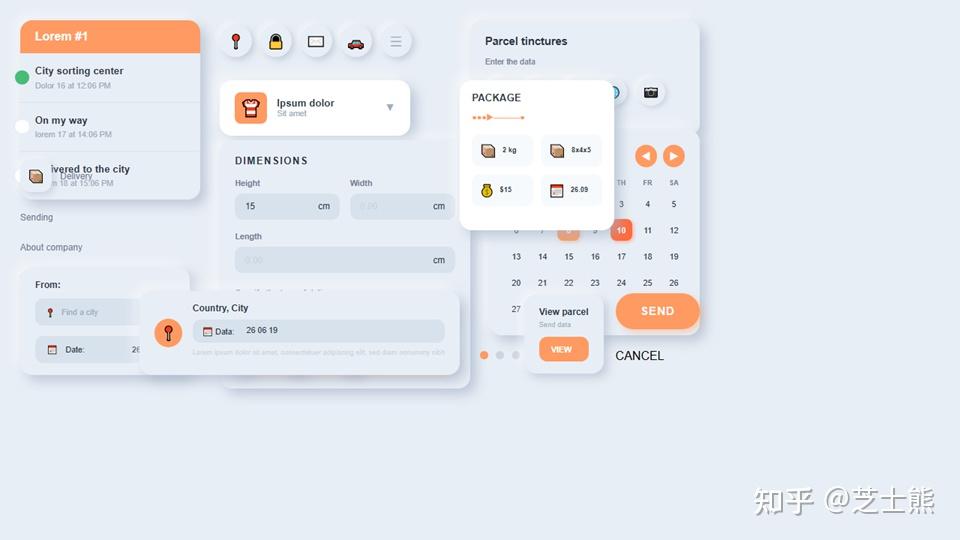

今天在玩用大模型生成 ppt 的时候(本质还是在生成前端),发现 GLM 的空间感似乎比 claude4.5 好。。非常意外。

空间感在大模型前端生成里是一个挺难的问题,之前和游戏引擎公司大佬交流的时候也说到过这点。元素 A 在元素 B 的 xxx 位置,大模型很难生成对。

一样的提示词,GLM 4.6:

CLAUDE 4.5:

补充:一个模型配置切换小技巧

如果你同时买了 claude 的套餐,同时也用 glm 的 coding plan,你可以在 setttings.json 文件中配一个无意义的字段,比如这里的"_GLM_settings"。

"env": {

"API_TIMEOUT_MS": "3000000",

"MCP_TOOL_TIMEOUT": "60000",

"_GLM_settings": {

"ANTHROPIC_AUTH_TOKEN": "your key here",

"ANTHROPIC_BASE_URL": "https://open.bigmodel.cn/api/anthropic",

"ANTHROPIC_DEFAULT_HAIKU_MODEL": "GLM-4.5"

}

},

那么你后续切换的时候,只要将这几行 glm 相关的配置移入移出{}、增加/删掉一个逗号就可以切换了。大概花费 5 秒钟。

当然也有好几个开源的小工具,可以系统化的管理,但我觉得太重了。自己动手、方便快捷。

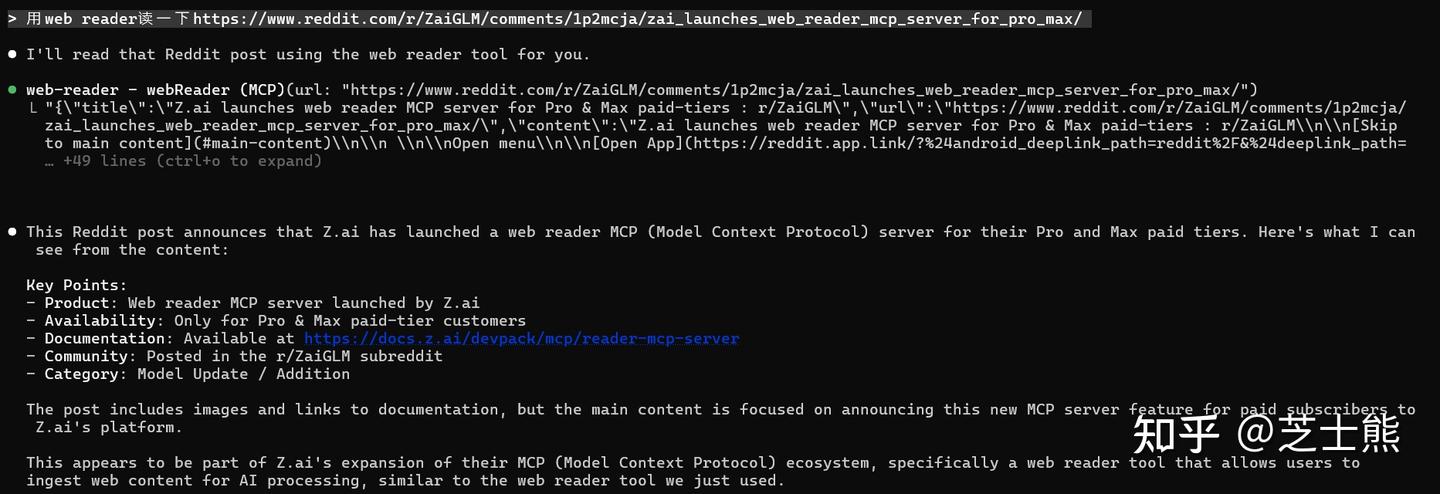

补充:GLM 前几天增加了一个 web reader mcp

对标到 Claude Code 原生[WebFetch](https://zhida.zhihu.com/search?content_id=263773808&content_type=Article&match_order=1&q=WebFetch&zd_token=eyJhbGciOiJIUzI1NiIsInR5cCI6IkpXVCJ9.eyJpc3MiOiJ6aGlkYV9zZXJ2ZXIiLCJleHAiOjE3NjgzMDAyOTEsInEiOiJXZWJGZXRjaCIsInpoaWRhX3NvdXJjZSI6ImVudGl0eSIsImNvbnRlbnRfaWQiOjI2Mzc3MzgwOCwiY29udGVudF90eXBlIjoiQXJ0aWNsZSIsIm1hdGNoX29yZGVyIjoxLCJ6ZF90b2tlbiI6bnVsbH0.rcDMSV14FFPJCp6W4zM-5kpEnp0gIcYLVicBQtaRBw0&zhida_source=entity)工具,可以把 html 解析成大模型方便消费的 markdown 格式。

GLM 的 mcp 更强调结构化解析,标题、正文、元数据、链接列表这些字段会单独给出。

效果:

GLM 持续在迭代补充 coding 生态的能力,这一点还是很棒的。

来源:知乎原文整理