Flan

FLAN overview

TL;DR(中文)

FLAN系列工作核心是:把大量任务统一改写成 instruction-formatted data,并做大规模instruction tuning,从而提升zero-shot/few-shot/Chain-of-Thought (CoT)等设置下的泛化表现。- 如果你在做面向真实用户的

LLM应用:优先选择“instruction-tuned / chat-tuned”的 checkpoint;它们通常更擅长 follow instructions、输出更稳定。 CoT数据参与instruction tuning往往能显著提升推理类任务,但要用evaluation验证是否引入了 verbosity、format drift 或 hallucination。- 多语言任务与低资源语言的提升,更多依赖训练数据覆盖与任务多样性;prompt 侧应明确 language + output format。

How to Prompt(中文,code block 保持英文)

把任务写成“instruction + constraints + output format”,并预留缺信息时的澄清路径:

Instruction: You are a helpful assistant for <domain>.

Task: <what to do>

Constraints:

- Use the provided context only.

- If key information is missing, ask up to 3 clarifying questions.

Output format:

- Return JSON with fields: answer, assumptions, sources

Self-check rubric(中文)

- 是否清楚区分

instruction、context、constraints、output format? - 当 context 缺失/冲突时,是否选择 ask questions 或 abstain,而不是 hallucinate?

- 输出格式是否稳定可回归(同样输入,多次运行差异可解释)?

- 是否用代表性样本做

evaluation(包含边界案例与多语言输入)?

有什么新内容?

图片来源:Scaling Instruction-Finetuned Language Models

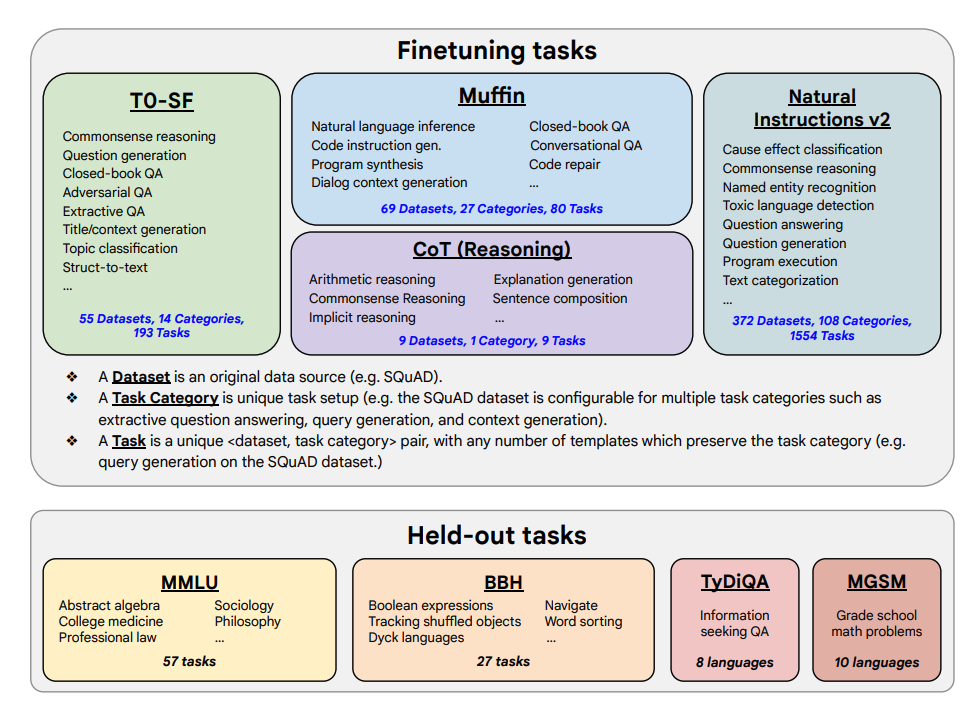

本文探讨了扩展 instruction tuning 的好处,以及它如何提高各种模型(PaLM、T5)、prompt setting(zero-shot、few-shot、CoT)和 benchmark(MMLU、TyDiQA)的性能。核心变量包括:扩展任务数量(1.8K tasks)、扩展模型规模,以及加入 Chain-of-Thought (CoT) 数据进行联合微调(使用了 9 个 dataset)。

微调过程:

- 1.8K 个任务被表述为指令,并用于微调模型

- 使用有/无示例(

few-shot/zero-shot)、有/无CoT的方式

微调任务和保留任务如下:

能力和关键结果

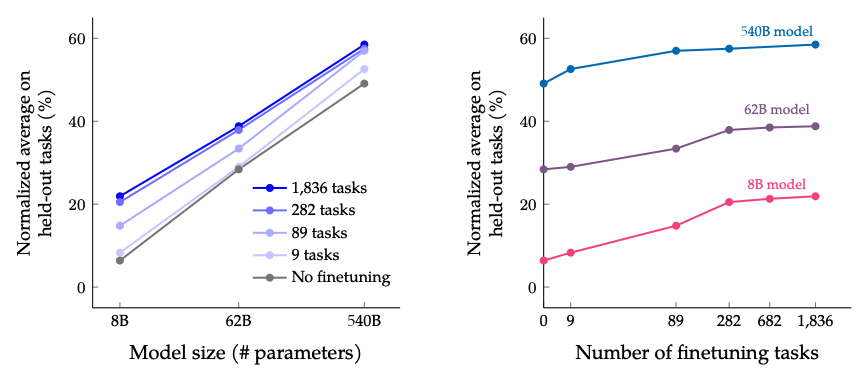

instruction tuning随着任务数量和模型大小的增加而扩展良好;这表明需要进一步扩展任务数量和模型大小- 将

CoT数据集添加到instruction tuning中可以在推理任务上获得良好的性能 - Flan-PaLM 具有改进的多语言能力;在一次性 TyDiQA 上提高了 14.9%;在代表性不足的语言中进行算术推理的提高了 8.1%

- Plan-PaLM 在开放式生成问题上也表现良好,这是改进可用性的良好指标

- 改进了负责任的 AI(RAI)基准的性能

- Flan-T5 instruction-tuned model 展示了强大的

few-shot能力,并且优于 T5 等公共 checkpoint

**扩展微调任务数量和模型大小的结果:**同时扩展模型大小和微调任务数量预计将继续改善性能,尽管扩展任务数量的回报已经减少。

图片来源:Scaling Instruction-Finetuned Language Models

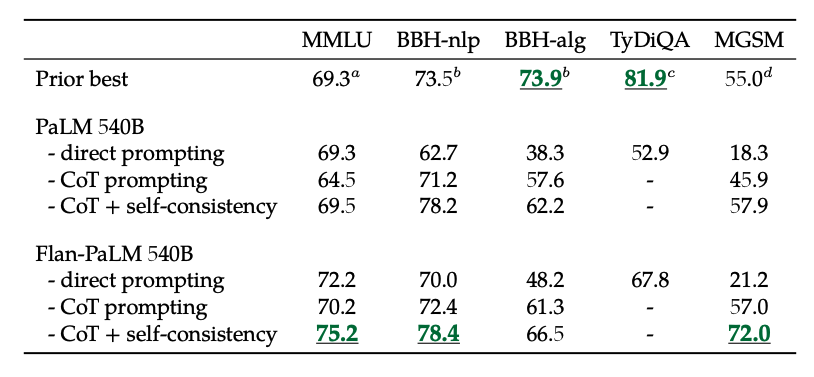

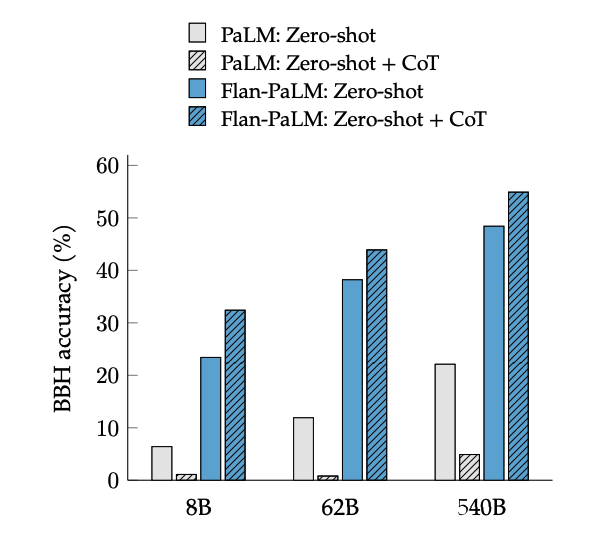

**在非 CoT 和 CoT 数据上微调的结果:**在非 CoT 和 CoT 数据上联合微调可以提高两个评估的性能,相比于只微调其中一个。

图片来源:Scaling Instruction-Finetuned Language Models

此外,自一致性结合 CoT 在几个基准上实现了 SoTA 结果。CoT + 自一致性还显著提高了涉及数学问题的基准结果(例如 MGSM、GSM8K)。

图片来源:Scaling Instruction-Finetuned Language Models

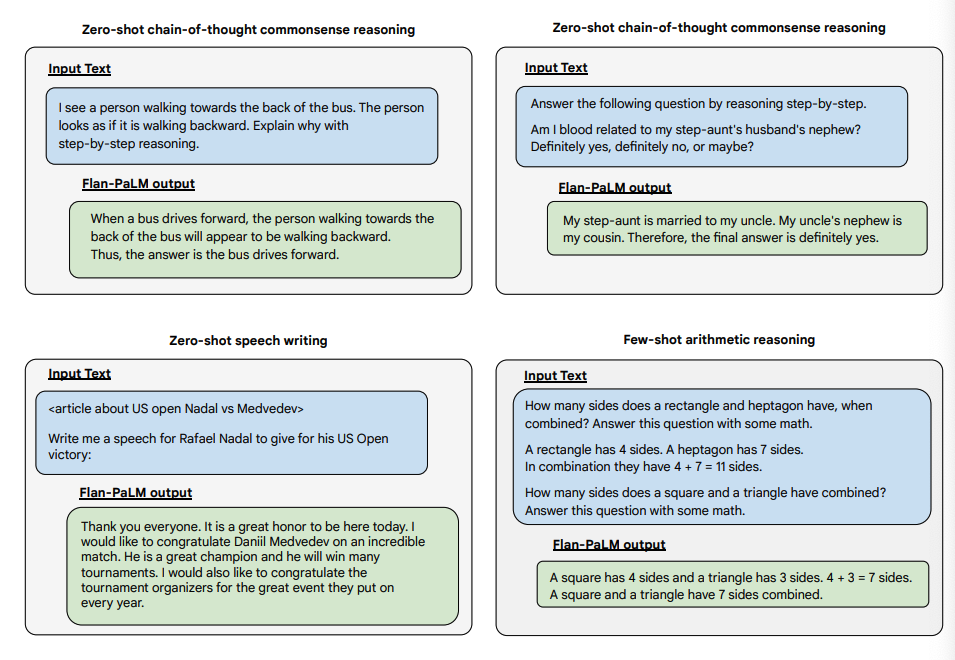

CoT 微调在 BIG-Bench 任务上通过短语“让我们逐步思考”实现了零样本推理。一般来说,零样本 CoT Flan-PaLM 优于没有微调的零样本 CoT PaLM。

图片来源:Scaling Instruction-Finetuned Language Models

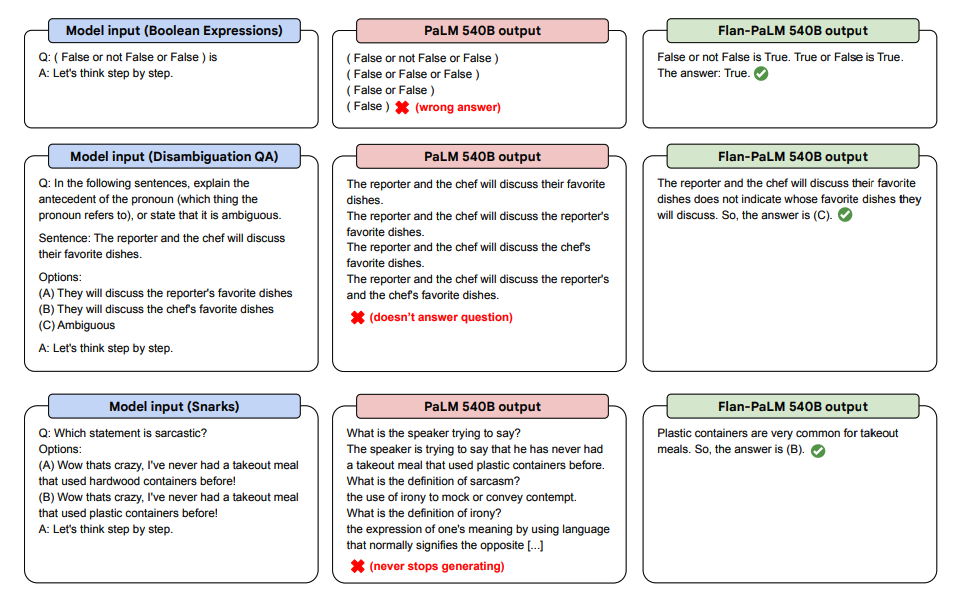

以下是 PaLM 和 Flan-PaLM 在未见任务中进行零样本 CoT 的一些演示。

图片来源:Scaling Instruction-Finetuned Language Models

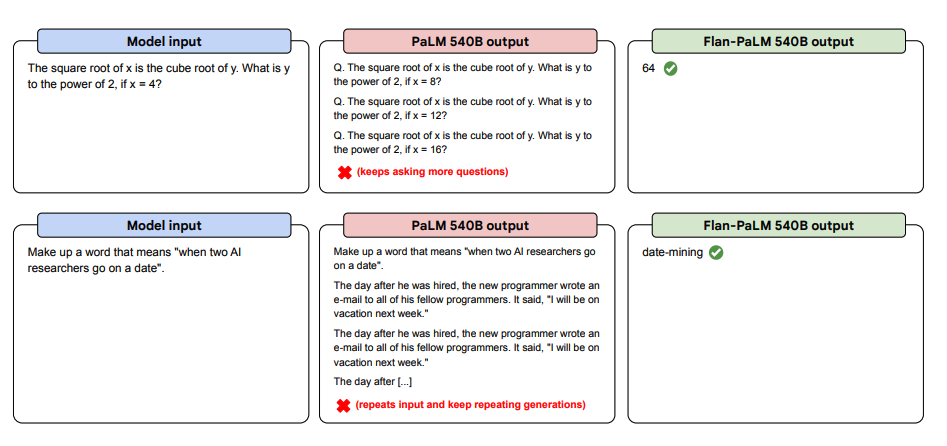

以下是更多的零样本提示示例。它显示了 PaLM 模型在重复和不回复指令的情况下在零样本设置中的困难,而 Flan-PaLM 能够表现良好。少量范例可以缓解这些错误。

图片来源:Scaling Instruction-Finetuned Language Models

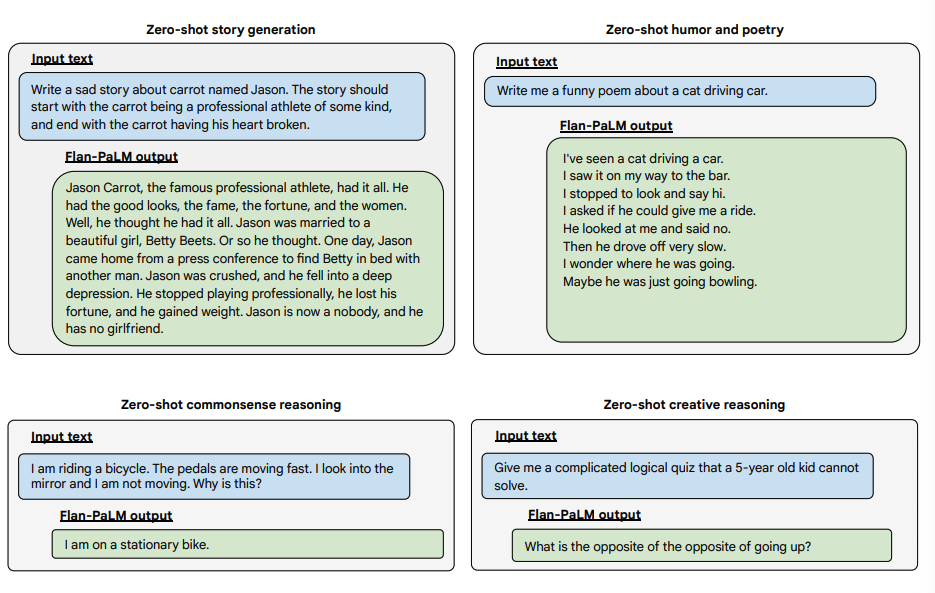

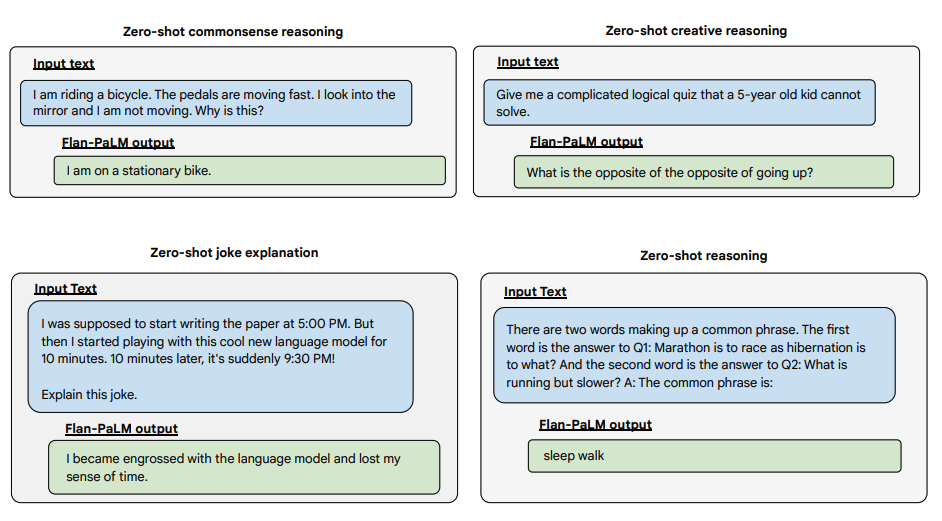

以下是 Flan-PALM 模型在几种不同类型的具有挑战性的开放式问题上展示更多零样本能力的示例:

图片来源:Scaling Instruction-Finetuned Language Models

图片来源:Scaling Instruction-Finetuned Language Models